Привет.

Невольно о теме предвзятости искусственного интеллекта заставила вспомнить полемика, запущенная в Совете Федерации, там предложили придумать способы, как обжаловать решения AI, сделанные относительно граждан, и как сделать их прозрачными. Разработчики искренне возмущены этим и считают, что создают если не идеальные, то безопасные системы с непредвзятыми суждениями и никакого регулирования не нужно вовсе. А скорее нужно объяснять, что AI безопасен. Ошибка суждения разработчиков в том, что они искренне считают созданные алгоритмы безопасными и правильными, не понимая, что, скармливая им большие объемы данных, они не могут регулировать их качество, что изначально создает ошибки, которые нельзя исправить.

Может ли человек быть дискриминирован алгоритмами искусственного интеллекта? Однозначный ответ возможен только один – да, может. В Америке, где исторически используется большое число компьютерных систем, помогающих анализировать данные, огромное количество примеров, показывающих такие ошибки. В современном американском обществе трудно вообразить вопрос, с каким цветом кожи люди чаще совершают преступления. Думаю, что у вас в голове уже есть стереотип и вы произнесли ответ, который не требует объяснений. И при этом вы не считаете, что дискриминируете кого-то, вам кажется, что вы правы, так как видели выступления BLM, лутинг, или, по-простому, грабежи. В стране, где насаждают политкорректность, такие вопросы нельзя задавать и тем более так думать. Чем-то напоминает ситуацию с продуктами в Советском Союзе, на полках магазинов шаром покати, а домашние холодильники ломятся от снеди.

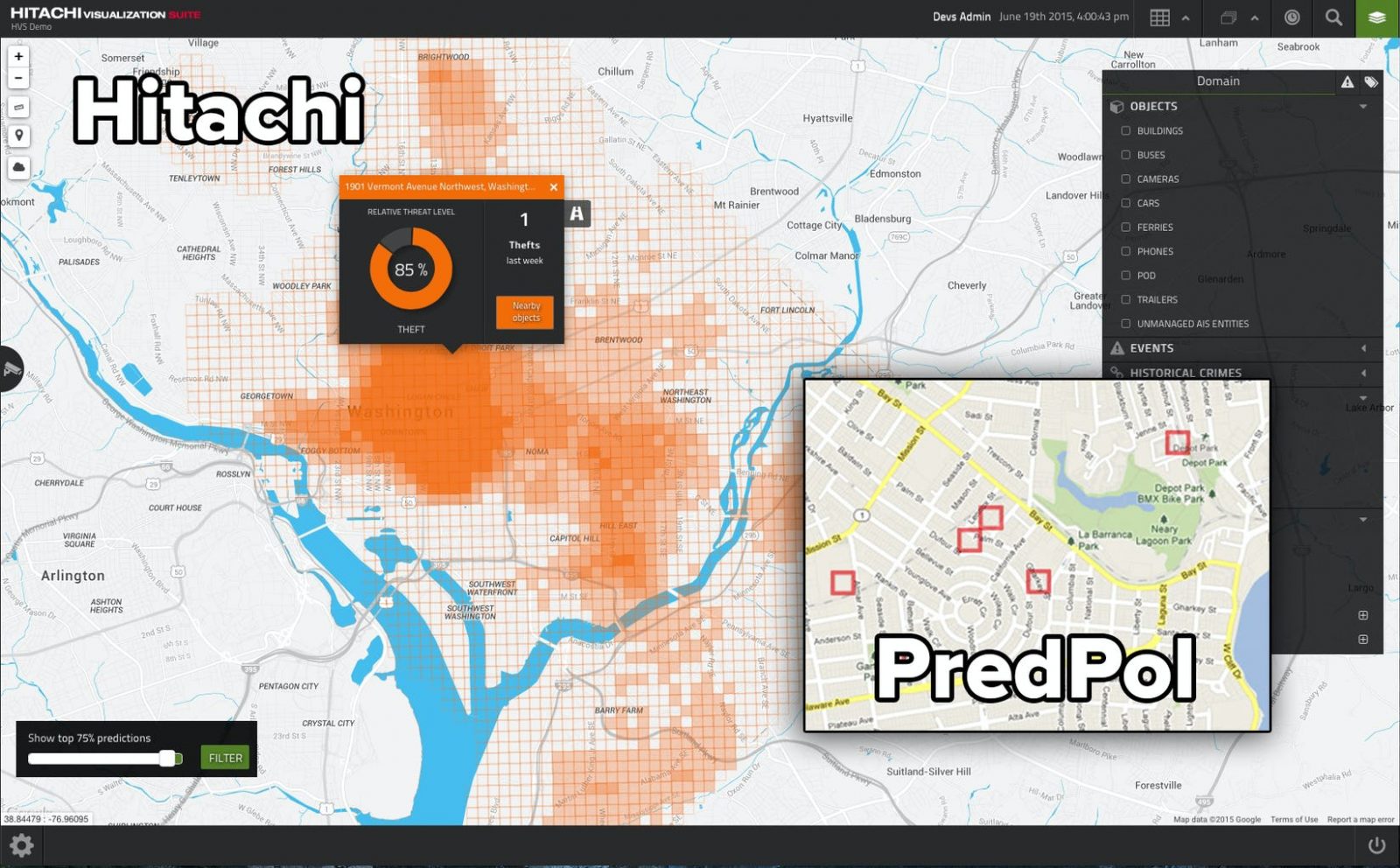

Двойственность нашего сознания сформирована обществом, человек умеет притворяться и приспосабливаться, этого начисто лишены компьютерные алгоритмы, они однозначны в своих суждениях. В Лос-Анджелесе департамент полиции запустил проект PredPol, в котором предсказываются на основании данных о совершенных преступлениях районы, в которые нужно отправить большее число патрулей, чтобы предотвратить новые инциденты.

Для полиции не стало неожиданностью, что система моментально обозначила в качестве проблемных районов те, где преимущественно живут чернокожие люди. Вот даже сейчас я невольно написал «чернокожие люди», словно в слове «негры» содержится что-то неправильное, хотя контекст этого слова испорчен исключительно в Америке. Дискриминация по цвету кожи — одна из болезненных тем для Америки, и то, что система работает именно так, возмутило многих людей. И тут мы сталкиваемся сразу с несколькими ключевыми проблемами работы AI-алгоритмов, и они лежат вовсе не в плоскости технологий. Людям зачастую не нравятся те результаты, что показывают AI-алгоритмы, так как они противоречат их вере или убеждениям. Например, один из активистов, пропагандирующих очередной гендер для человечества, искренне возмущался тем, что его поддерживает меньше сотни человек в стране с населением в триста миллионов. Ему не нравились результаты статистики, хотя в них нет предмета для споров, так как это цифра и ничего больше.

Мусор на входе означает мусор на выходе. И тут мы подходим к ключевой проблеме любого алгоритма, к тому, какие данные скармливают системе для анализа. В истории с полицией в Лос-Анджелесе это были настоящие полицейские отчеты, и понятно, что в неблагополучных районах число преступлений было большим. Система, отправляя большее число патрулей в такие районы, автоматически приводила к росту зарегистрированных правонарушений, что логично. Чем больше машин полиции в районе, тем больше вероятность зафиксировать правонарушение. Сформировалась положительная обратная связь, которая не доказывает, что система работает правильно, она сама формирует конечный результат.

Другая система, используемая в Америке, называется COMPAS, она позволяет оценить вероятность повторного правонарушения. Среди чернокожих граждан система предсказывала в два раза больше случаев рецидивизма, при этом они оказывались ложными. Проблема тут ровно та же, ошибочные суждения, заложенные в изначальный объем данных, что скормили системе.

Весь наш мир построен на предвзятости, и исключений из этого правила нет. Когда помощь просит молодая и красивая девушка, то большинство мужчин готовы откликнуться и помочь. Совсем другое дело, когда в помощи нуждается человек, который нам по каким-то причинам неприятен. Справедливости нет и не может быть, идеального общества роботов не существует. И наше право на эмоции формирует другое восприятие мира, которое невозможно изменить.

Огромной областью для будущих разработок является очистка данных для систем машинного обучения, чтобы итоговый результат совпадал с нашими представлениями о прекрасном. Например, число прогнозируемых преступлений для людей с разным цветом кожи было одинаковым — над этой задачей в США бьется несколько групп энтузиастов. Но мы с вами понимаем, что такая задача выглядит идеалистичной и не реализуемой на практике. Дискриминация по цвету кожи реальна, и она накладывает свой отпечаток на жизни людей, зачастую толкает кого-то на преступления. И системы в лучшем случае могут это показать, но не исправить этот порок общества.

Если мы не можем решить задачу с исходными данными, это значит, что нужно уметь манипулировать итоговым результатом. Как минимум понимать, как он сформирован и какой была логика алгоритма. И вот тут возникает новый пласт проблем, зачастую машинное обучение не дает нам алгоритм и не показывает логику решения, а просто сообщает результат. Черный ящик — вот как выглядит для нас алгоритм, а результат предлагается принять на веру. И это то, что заботит разработчиков, ведь если общество обяжет их объяснять, как работают алгоритмы, раскладывать их на составляющие, то прогресс в этой области замедлится. Огромная часть времени будет уходить на анализ результатов, изучение того, как работают алгоритмы, и это то, чего большинство просто не делает.

Чем-то мне это напоминает голливудские фильмы, в которых главные герои что-то изучают, куда-то бездумно идут и потом начинаются проблемы. Они просто жмут кнопки, предназначение которых им неизвестно, если есть кнопка, то на нее нужно обязательно нажать. Разработчики AI-алгоритмов очень похожи на таких героев, они ровно так же не задумываются об анализе результата своей работы, свято верят в алгоритмы, которые написаны верно, и откидывают размышления об изначальном объеме данных.

Посмотрите на тот же «Яндекс» и их сервис такси. Любой вопрос о том, как получена цена на поездку, натыкается на заученный ответ: у нас умный алгоритм, он анализирует множество данных и выдает справедливую цену для каждого. Но любая попытка узнать, как именно работает этот алгоритм и не подыгрывает ли он «Яндексу», чтобы корпорация зарабатывала больше, натыкается на то, что никто этого не знает. То есть мы покупаем поездку на такси и нам предлагают заранее согласиться, что цена справедлива.

Представьте на минутку, что вы приходите в продуктовый магазин, где покупаете сахар. Берете пакет сахара, его цена может различаться. Но помимо цены также различается и то, сколько сахара в пакете, каждый раз это должно стать сюрпризом. Примерно так и работает «Яндекс.Такси» сегодня, регулируя не только стоимость условного сахара, но и то, сколько его в пакете. Поле для злоупотреблений тут огромное, но главное, что есть алгоритм, на который можно все свалить. И тут есть еще одна проблема, которую важно понимать, — люди перекладывают на алгоритм всякую ответственность, хотя именно люди его создали и должны отвечать за то, как он работает.

Очарованность AI-алгоритмами в обществе будет постепенно проходить, мы научимся их контролировать, равно как и заставим разработчиков объяснять, что и как работает. Например, производители, которые создают оксиметры, столкнулись с возмущением пользователей в ряде стран, когда пользователи жаловались, что в инструкции отмечено отличие данных для чернокожих и людей с белой кожей. Принцип работы такого прибора прост — он просвечивает кожу и оценивает кровоток. В зависимости от прозрачности, читай — цвета кожи, алгоритм подсчета различается, и это нужно учитывать при оценке результатов. Никакой дискриминации здесь нет и в помине, различия лежат в физическом мире, и они реальны. Но в рамках политической повестки люди бездумно протестуют против различий для черных и белых, словно их нет в реальном мире и они выдуманы. Наш мир сегодня заигрался в корректность, и AI-алгоритмы хотят ломать на другом конце, иметь возможность вмешиваться в результаты их работы, чтобы они были политкорректными.

Полезность AI-алгоритмов признают многие, но одновременно с этим говорят о том, что люди не подготовлены к тем результатам, которые они дают, они могут их шокировать. И поэтому в таких системах нужно вводить возможность ручного управления, давать человеку вмешаться в итоговый результат. И тут могут быть как правильные, так и неверные решения.

Приведу пример с системами видеонаблюдения на дорогах Москвы. Когда вы попадаете под камеру, нарушаете рядность или скоростной режим, то вам прилетает штраф. Формально число штрафов, что должны получать водители, в несколько раз больше, чем то количество, что выписывается. Почему так? Это вопрос спокойствия в обществе, водителей постепенно приучают к тому, что нужно соблюдать правила дорожного движения, не пытаются создать шок в обществе. И такой подход работает, число нарушений постепенно становится меньше, люди чаще соблюдают скоростной режим, начинают водить машину иначе.

Тема AI-алгоритмов популярна, и кажется, что они становятся палочкой-выручалочкой. К сожалению, их возможности сильно преувеличивают. Есть области, в которых AI-алгоритмы показывают неплохие результаты, так как первоначальные данные представлены правильно и в большом объеме. Но в любом случае наши предпочтения и пороки влияют на AI-алгоритмы и данные, искажают итоговый результат. Я не верю в то, что тысячи лет цивилизации неожиданно изменят AI-алгоритмы, которые сделают нас другими. Ложь, поиски личной выгоды, манипуляция данными и тому подобные проявления человеческой природы никуда не исчезнут. Поэтому главной задачей становится понимание того, как работают такие алгоритмы, возможность откатить назад их решения. Иначе наш мир грозит стать очень странным и подчас страшным местом.