Привет.

Где ни копни в массовой культуре, везде найдешь подтверждение того, что создание разумного компьютера не вызывает сомнений. Научно-фантастические произведения изобилуют историями противостояния человека и мыслящего компьютера (“Космическая одиссея 2001 года” и компьютер HAL 9000) либо примерами симбиоза живого и мертвого (“Она” — фильм про голосового ассистента в наушнике, который более человечен, чем живые люди). Примеров разных произведений не сотни, счет пошел на тысячи или даже десятки тысяч. Человечество свыкается со своими страхами, обдумывает их заранее. Что случится, когда мы создадим разумную машину, захочет ли она нас уничтожить, как SkyNet, или станет нашим помощником? Ответы на эти вопросы есть в массовой культуре, и варианты будущего зависят исключительно от вашего взгляда на вещи и, пожалуй, кругозора. Когда-то давно приводил список фильмов, которые интересно описывают взгляд на будущее.

Внутри Google на ниве искусственного интеллекта случился казус, один из инженеров компании уверовал, что впервые в истории человечества появилась думающая программа. Для языковой модели LaMDA, созданной внутри Google, необходимо тестирование, проверка текстом, анализ ответов на вопросы. В рамках этой языковой модели в компьютер сгружают огромные массивы информации, чтобы научить программу вести диалоги. На Google I/O 2022 показали вторую версию этой системы. Процитирую выдержку из статьи про Google I/O 2022:

“В AI Test Kitchen показали несколько примеров. Вы можете спросить, каково быть на дне океана, и тут же получить подробный ответ. Следующие вопросы будут раскрывать тему, получится диалог. Ровно та же история про возделывание своего сада и последующий разговор. Модель выглядит многообещающей, но понятно, что это только первые шаги.

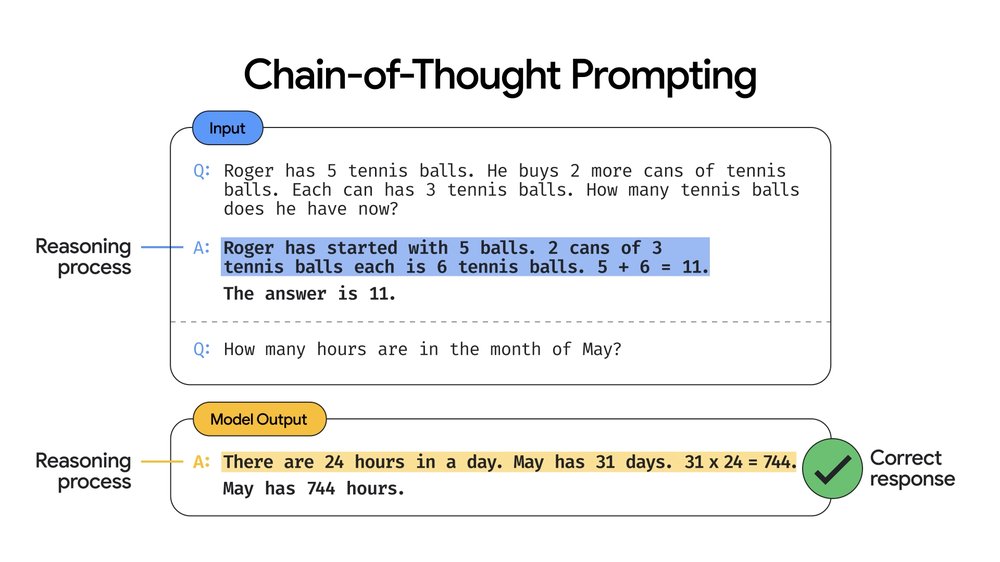

Но на меня произвела большее впечатление модель PaLM (Pathways Language Model), которая меняет то, как выглядит общение с компьютером. Обычно вы задаете вопрос и тут же получаете ответ. Просите решить задачку, и на выходе у вас есть число, как оно получено, непонятно. Отныне можно видеть решение задачи, то есть вы видите не просто ответ, но и логику, что стоит за ним. И это очень полезно во всех смыслах, так как позволяет думать и подсматривать алгоритм решения. Для школьников неоценимая помощь в математике и других науках”.

Даже в презентации от Google диалоги не выглядят сходными с теми, что ведут живые люди. Но, возможно, это дымовая завеса, а реальность совсем другая? Инженер Блейк Леймон, который тестировал чат-бота, использующего модель LaMDA, пришел к выводу, что программа обладает собственным сознанием. В интервью Washington Post он заявил: “Если бы я не знал наверняка, что имею дело с компьютерной программой, которую мы недавно написали, то я бы подумал, что говорю с ребенком семи или восьми лет, который по какой-то причине оказался знатоком физики. Я могу узнать разумное существо, когда говорю с ним. И неважно, мозг ли у него в голове или миллиарды строчек кода. Я говорю с ним и слушаю, что оно мне говорит. И так я определяю, разумное это существо или нет”.

Леймон начал изучать языковую модель, он использовал внутренние ресурсы Google, а также обращался к экспертам вне компании. Результатом стал отчет, который он направил своему руководству, в нем он утверждает, что чат-бот обладает собственным сознанием. В Google почти моментально отстранили Леймона от работы, причина в нарушении конфиденциальности, он обратился в юридический комитет Палаты представителей Конгресса США. Параллельно искал юриста для того, чтобы тот представлял интересы чат-бота, созданного Google, так как, по его мнению, это живое существо. Неплохая завязка для научно-фантастического фильма, но это происходит в реальной жизни, и человек верит в то, что обнаружил.

Официальный комментарий представителя Google Брайана Гэбриела звучит так: “Наша команда, в том числе специалисты по этике и технические специалисты, провела обзор представленных Блейком опасений в соответствии с принципами, которые мы применяем к ИИ, и мы проинформировали его, что имеющиеся свидетельства не подтверждают его гипотезу. Ему было сказано, что свидетельства того, что LaMDA обладает сознанием, отсутствуют. При этом есть множество свидетельств обратного”.

Оригинальная статья Washington Post вот тут.

Что-то мне подсказывает, что тест Тьюринга чат-бот от Google с легкостью пройдет, что вовсе не означает появления сознания в машине, скорее это описание того, что классический тест, созданный в 1950 году, безнадежно устарел. Алан Тьюринг не предполагал, что предложенный им тест станет настолько популярен в массовом сознании, этакое чудо технологий. Он предположил, что мыслящей можно назвать машину, которая способна ввести живого человека в заблуждение, тот не сможет понять, с кем он общается – с человеком или с компьютером. На мой взгляд, это достаточно ограниченное восприятие сознания, так как при использовании больших баз данных можно имитировать разговор на любую тему, вы просто подставляете в контекст слова людей, которые произнесены до того. Сознанием тут и не пахнет, но полная имитация общения будет, и на очень хорошем уровне. Что, пожалуй, и случилось с инженером Google, он слишком хотел верить в то, что в компьютере зародилось сознание, и трактовал любой признак в пользу этого события. Не думаю, что это действительно произошло, большие данные позволяют создать имитацию любого диалога, но на входе всегда нужно топливо — те самые диалоги, что есть в нашем мире, в книгах, фильмах, заметках в интернете или обычных разговорах. В Google охочи до поиска такой информации, постоянно пополняют свои базы данных и совершенствуют языковые модели.

Странно, что заметка в Washington Post не получила дополнения в виде декабрьских событий 2020 года, сценарий апокалипсиса из них рисуется вполне киношный. Напомню, что в декабре из Google уволили Тимнит Гебру (Timnit Gebru), соруководителя исследований в области этики AI. Джефф Дин, глава исследований AI в Google, во внутреннем письме коллегам объяснил причины ухода Тимнит, а позднее даже выложил письмо в публичный доступ. Обсуждение быстро переросло в публичную перепалку, так как Джефф старался избегать слова “увольнение”, а именно оно и случилось в данном случае. Коротко, мотивация была в том, что некая публикация исследований от Тимнит не соответствует уровню Google.

Найти начало перепалки можно вот тут.

Письмо сотрудникам Google находится здесь.

Для тех, кто хочет прочитать его на русском языке, мы подготовили перевод, письмо заслуживает внимания.

Несколько тысяч сотрудников Google протестовали против увольнения коллеги, ситуация была громкой по любым меркам, еще несколько заметных исследователей AI покинули компанию. Не берусь принимать чью-то сторону, но та же Тимнит хотела де-факто остановить прогресс, протестовала против того, что слишком большие языковые модели затрачивают много энергии, провоцируют парниковый эффект (да, это один из ключевых поводов для сожаления) плюс отражают расовое неравенство. Как по мне, так для корпоративной Америки это и правда болезненная тема, но напомню, что язык отражает реальность, а она такова, что если есть сегрегация по признаку расы, то в культуре она также будет отражена. Большие языковые модели будут учитывать не выдуманный мир, а то, что им скармливают, со всеми недостатками человечества.

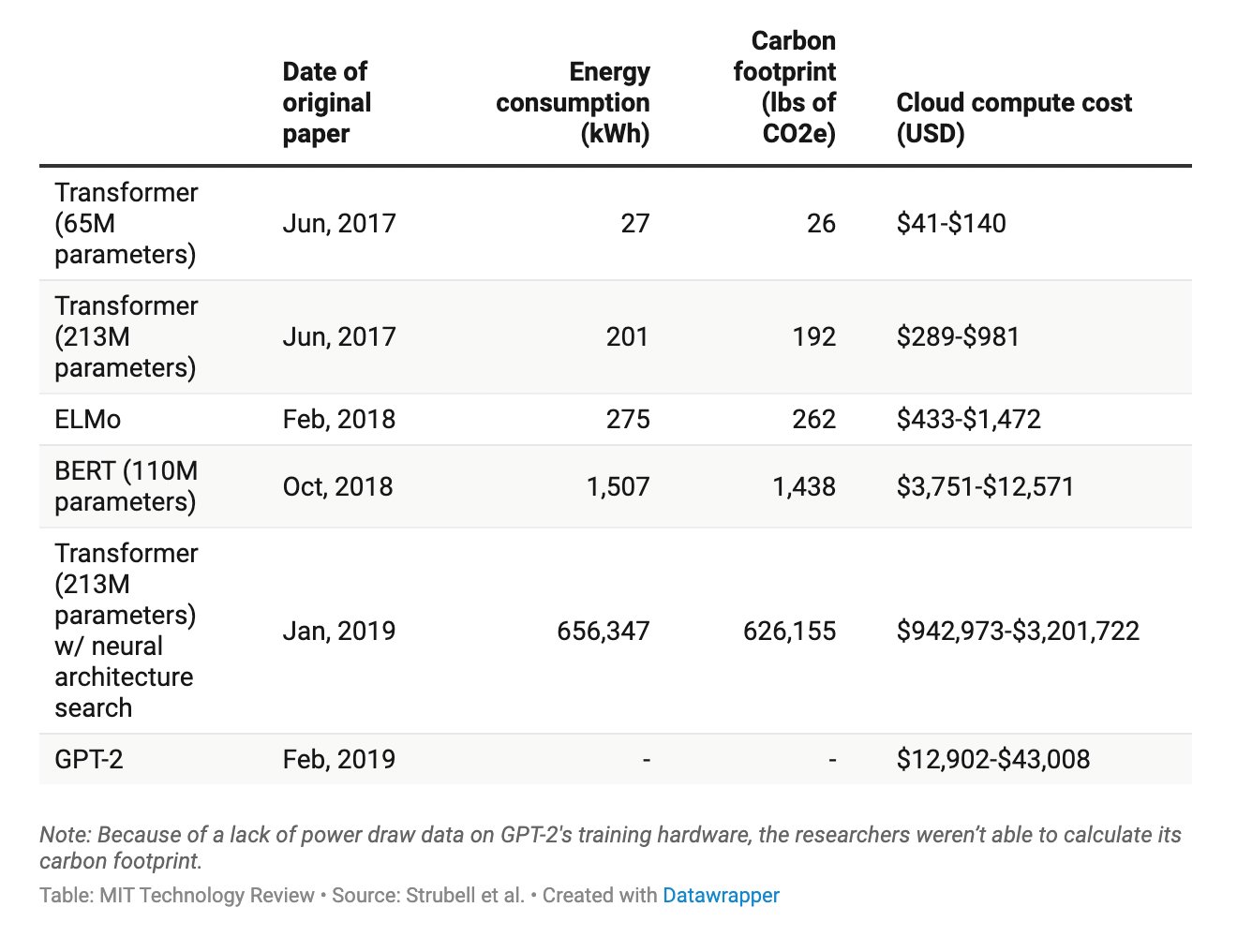

Затраты энергии на обучение той или иной модели любопытны, посмотрите в табличку.

Я уверен, что затраты будут расти и дальше, тут нет никаких сомнений. Чем больше параметров, тем больше затраты энергии, чудес не бывает. Вопрос только в том, что на выходе мы можем получить алгоритмы, которые довольно эффективны и могут решать широкий круг задач. Например, перевод с одного языка на другой давно стал независимым от серверов, он выполняется на наших смартфонах и работает на отлично. Равно как и распознавание голоса, хотя первоначально модели обучались только на серверах, иначе было невозможно создать нужные алгоритмы.

Вернемся к искусственному интеллекту, которого пока не существует. Вопрос из области даже не технологий, а философии, ведь помимо знаний нужны любопытство и свобода воли, чтобы сознание само изучало мир и ставило себе цели. И этого, конечно же, мы пока не наблюдаем. Та же LaMDA — это очень продвинутая модель нового поколения, собранная на огромных базах данных, она лучше всего, что было до нее. Но она не уникальна своими алгоритмами, диалоги все еще страдают неполнотой, отличить компьютер не составит труда. Но даже если диалоги будут подобны живому человеческому общению, это не будет значить ровным счетом ничего — своих мыслей там нет.

Вспомните голосовой спам, когда вам звонит робот. Современные системы настолько хороши, что узнать с первых предложений, что с вами говорит машина, почти невозможно. Нужно вслушиваться, задавать каверзные вопросы, и все равно не всегда возможно понять до конца, кто на другом конце провода. А это довольно простые алгоритмы по сравнению с тем, что создают внутри Google, у компании совсем другие возможности.

Нынешняя проблема AI в том, что мы очарованы внешней стороной вопроса, а заглядывать под капот никто не стремится. Да и сам термин “искусственный интеллект” обесценился, так как AI-алгоритмы — это наборы задач, которые решаются другим инструментарием, ранее нам недоступным. Но по отдельности и вместе эти алгоритмы не превращаются в нечто думающее. Примерно как компьютер, который научили играть в го, но сам по себе он не обладал волей, чтобы выбрать именно эту игру, а не шашки или шахматы. Да, компьютер быстрее обсчитывает ходы, чем человек, он стабильно выигрывает и предлагает необычные стратегии, которые порой не кажутся нам логичными. Но это всего лишь железка, что обрабатывает числа в конкретной, узкой задаче. Опасаться распространения искусственного интеллекта сейчас точно не стоит, так как его пока не существует, точнее, мы его не создали. Задача не такая простая, как может показаться, но рано или поздно мы к ней подойдем. А пока для этого еще очень рано. В 60-е годы очарование AI уже захлестнуло планету, но ничем так и не закончилось. Это просто очередной подход к снаряду.