Привет.

Говорят, царь не настоящий! Примерно так можно отреагировать на очередную историю, в которой пытаются вывести на чистую воду Samsung, якобы компания подменяет Луну на снимках. Очередной подход к снаряду на Reddit, один из пользователей с большой помпой рассказывает о своем эксперименте: он первым в мире доказал, что Samsung использует AI-алгоритмы, чтобы дорисовывать Луну. Прочитать этот победный пост можно вот тут.

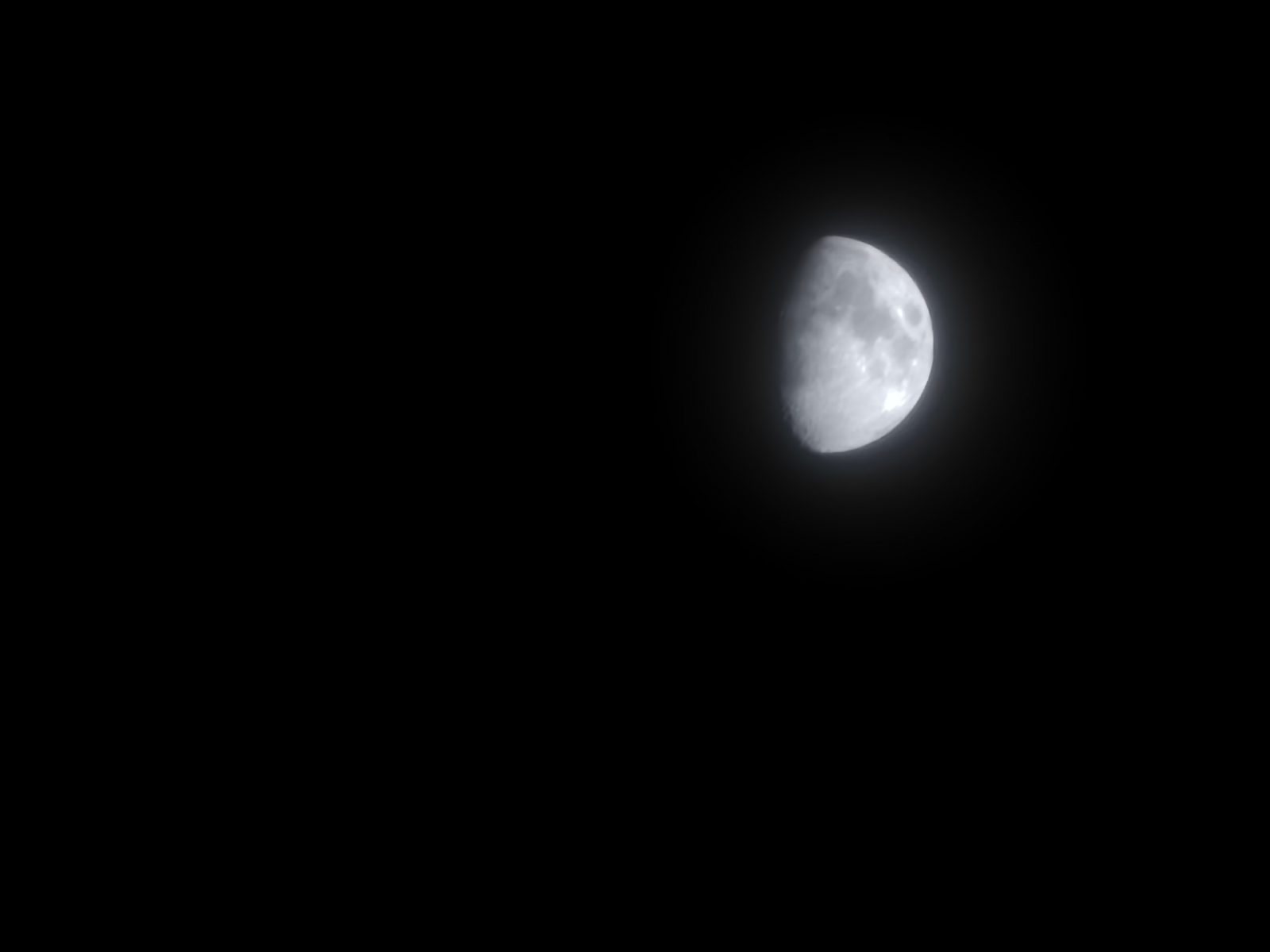

Если кто-то считает, что самое время защищать Samsung, говорить, что Луна настоящая и далее по списку, то вам точно не стоит читать текст. Но вначале несколько снимков Луны, что были сделаны мной на Galaxy S22 Ultra или S23 Ultra: цифровой зум х30, съемка с рук. В том числе огромная Луна, что случилась на днях в Петербурге.

Поверить, что небольшое устройство в ваших руках способно снимать с таким качеством и на таком расстоянии, практически невозможно. Наш “здравый смысл” подсказывает, что тут кроется обман. И это несмотря на то, что Луна, в целом, не тот объект, что сильно меняется, в конце концов, в Huawei как раз заменяют картинку Луны одной из тех, что находятся в базе данных (сегодня от такого подхода компания уже отказалась, теперь это реальные снимки спутника Земли).

Если бы Samsung меняла картинку, мы получали бы снимки совершенно другого качества, и, кажется, этот довод подействовал, теперь придумали другое объяснение — снимки обрабатывает AI-алгоритм. Пойду дальше, чем автор эксперимента, и скажу, что вне зависимости от настроек камеры, от того, включена оптимизация снимков или нет, все они подвергаются цифровой обработке. Все без исключения!

Хотите добиться снимка без обработки или с минимальной обработкой — тогда будьте добры пожаловать в режим “Про” попытать счастья с RAW-файлом. И вот в нем вы сможете увидеть “сырой” снимок, который не искорежен алгоритмами в угоду красивому отображению на экране телефона. Впрочем, чего я тут жалуюсь, мне большая часть снимков нравится, “корежит” их красиво.

Когда немного распогодится, я обязательно проделаю эксперимент с RAW-файлом и посмотрю, какой получается Луна, насколько там задействованы алгоритмы, но уверен, что их работа есть и это касается не только и не столько Луны как таковой, сколько в целом снимков, сделанных на смартфоны (а еще поснимаю Луну с экрана монитора, где есть точки, что позволяют AI-алгоритмам лучше восстанавливать картинку).

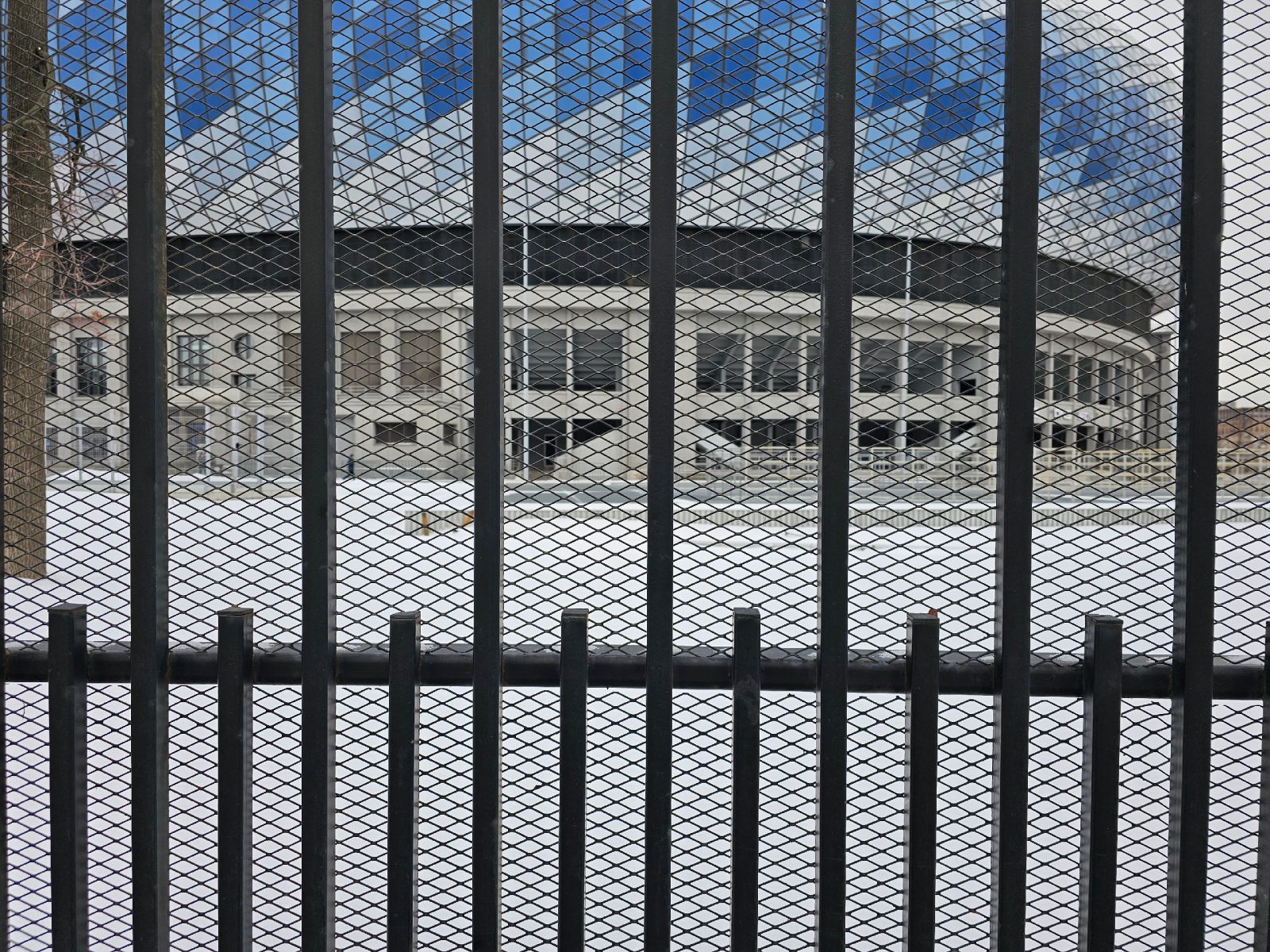

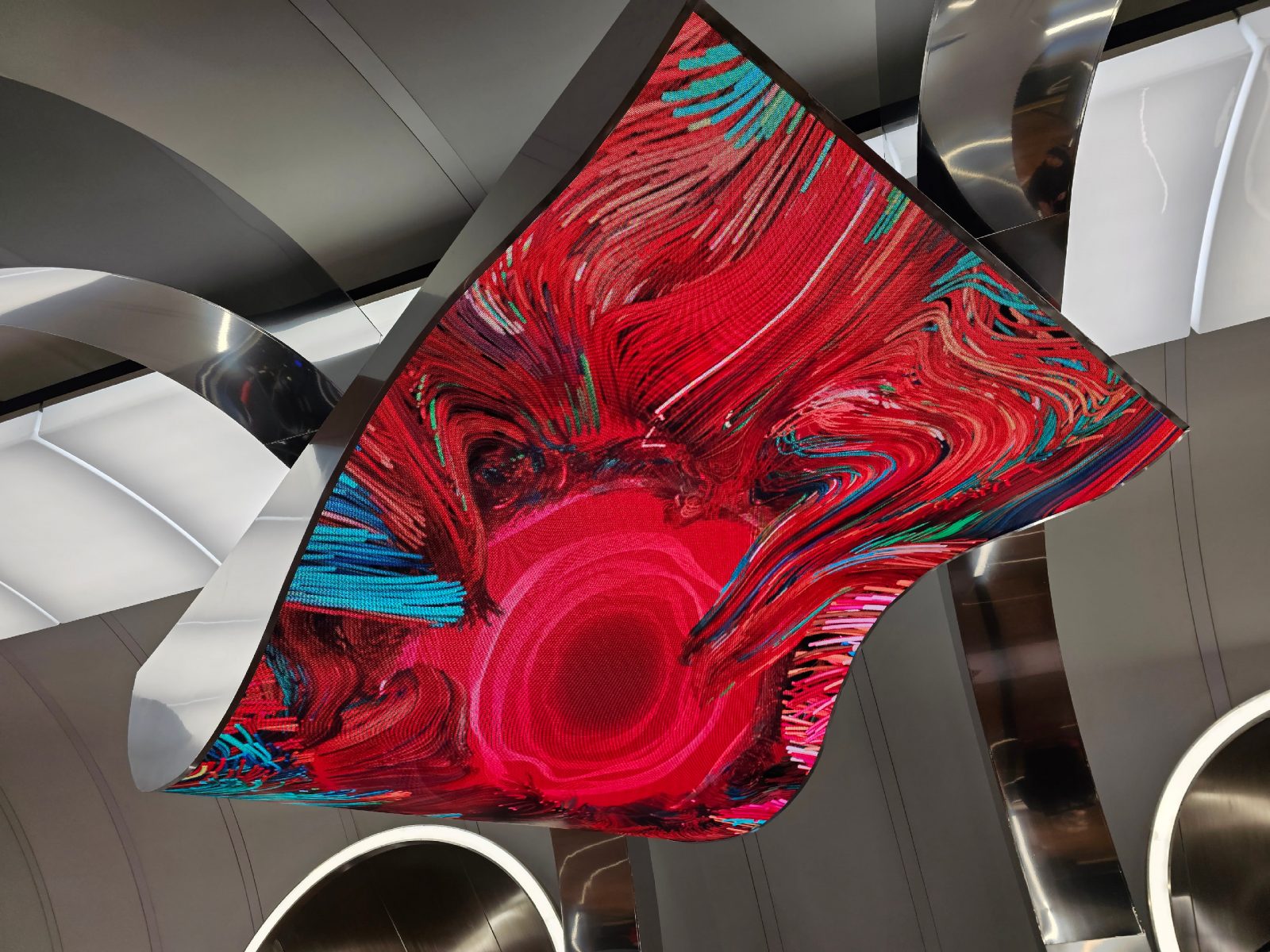

Луна как предмет съемки волнует крайне небольшое число людей (так и тянет написать что-то обидное, но я отношусь к таким людям, так что воздержусь от эпитетов). Но вот съемка других людей, архитектуры — это действительно важно в повседневной жизни. Давайте посмотрим на несколько снимков, сделанных с зумом х10 на Galaxy Ultra (два последних поколения, выделять их тут нет особого смысла).

Оптический зум в модуле камеры — штука крайне приятная, но мелкую дрожь рук при таком фокусном расстоянии нужно компенсировать, и этим занимаются алгоритмы. Они же угадывают расстояние до объектов, оценивают, что именно вы фотографируете, и даже подсказывают это на экране — появляется значок сцены, телефон меняет настройки под выбранный режим. Их сегодня уже более пятидесяти как у Samsung, так и у других компаний, определение сцены стало шаблоном для создателей камер. И если даже вы отключили AI-улучшалки, они все равно работают, просто не в таком агрессивном режиме. Причем началась эта история еще на цифровых камерах, а только потом ее позаимствовали смартфоны.

У нас все, что снимается на смартфоны, так или иначе “украшается” алгоритмами, вычислительная фотография вытягивает снимки на новый уровень. Поэтому когда начинают рассуждать про честную фотографию, тут нужно очертить предел, до которого мы считаем снимок отражением реальности и после которого он ее уже искажает. Например, снимки на аппараты линейки Pixel от Google в свое время поражали качеством портретов. Мы проделали эксперимент и сфотографировали разных девушек, с разными оттенками и структурой волос. Каждый снимок был если не идеален, то очень привлекателен — вот только волосы у каждой оказались плюс-минус одинаковыми, потерялась их индивидуальность. Причина в вычислительной фотографии, и тут нужно определиться, что нам нужно — красивый снимок или реальное отображение мира вокруг. На словах большинство за реальное отображение мира — как может быть иначе? На деле люди выбирают те устройства, что рисуют красивые картины этого мира. Вот такая несложная диалектика, которая толкает производителей на развитие вычислительной фотографии. Хотя это и не единственная причина, их намного больше.

Когда вы задействуете камеру, любой из доступных модулей в сложных условиях освещения, начинает работать целая тьма алгоритмов — каждый из них подбирается под конкретный случай и под то, что перед вами. В итоге вы получаете снимок, который способен вас порадовать, причем не всегда это то, что вы видите своими глазами. Например, мне досаждает ночной режим съемки, когда город становится на снимке светлым, словно вы фотографируете в сумерках.

Теряется очарование фонарей, теней вокруг, приходится переходить на ручной режим и снимать так, как нравится мне. Хорошо, что возможность ручной съемки не отняли и она у нас присутствует.

Пожалуйста, давайте не будем спорить о том, что современные устройства используют различные алгоритмы для улучшения качества снимков, некоторые из них настроены нейросетями. Факт! И никто с этим спорить не будет. Есть ли производители, что пытаются настроить нейросеть на конкретные объекты? Я таких не знаю, скорее это целый класс задач, в которых улучшается качество для различных снимков, — но картинка не дорисовывается, она, если так можно сказать, восстанавливается. Слишком много вокруг объектов, что могут попасть в камеру, и натренировать нейросети на каждый из них невозможно, проще создать алгоритмы, которые умеют вытягивать любой снимок — разбивать его на части, анализировать составляющие снимка, а затем собирать его вместе, повышая четкость, цветопередачу.

Вот вам несколько снимков с Galaxy S23 Ultra, представить, что так будет снимать смартфон, в 2010 году было невозможно, это казалось недостижимой высотой — сегодня это уровень флагманов. И надо сказать за это спасибо вычислительной фотографии.

Наверное, поэтому меня удивляет утверждение, что камера в смартфоне пытается улучшить снимок, в конце концов, это нормально. Более того, камера искренне считает, что это не Луна или картинка Луны на мониторе размыта, а она видит объект с дефектами. И, значит, нужно улучшить картинку. Скажу больше, конкретно в линейке Galaxy далеко не каждый раз включаются алгоритмы улучшения снимка. Например, при съемке в помещении монитора был задействован лазерный фокус, он измерял, и весьма успешно, расстояние до поверхности экрана. И при определении этого расстояния начинал работать алгоритм, который отвечает за съемку предметов поблизости, а вовсе не Луны. Вот такая эквилибристика, которую совершенно не учитывают, считая, что устройства глупы и всегда действуют по единожды заведенному сценарию. Сегодня телефоны уже настолько продвинуты, что вычленить то, как они фотографируют те или иные сцены, очень трудно, это набор крайне сложных для восприятия функций. Попробую описать один реальный сценарий из начинки того же Galaxy, то, как камера видит окружающий мир: туман, освещенность столько-то люкс, в кадре три объекта на переднем плане, расстояние до них такое-то, один из объектов — человек, два других — неживые предметы. Фокусировка происходит на человеке, он главный в кадре, если только пользователь не установит точку фокусировки где-то еще. Переоценка композиции, получение снимка. Параллельно анализ снимка, декомпозиция и повторная сборка с улучшенными параметрами. Это только малая часть действий камеры, она занимает одну, максимум две секунды. И да, как ни крути, это вычислительная фотография.

P.S. Обязательно займусь экспериментами с Луной, очень интересно посмотреть, что выйдет, и повторить или опровергнуть то, что получил человек в своих опытах. Пока склоняюсь к тому, что это ошибочная трактовка результатов — улучшение снимков всегда идет за счет алгоритмов, но Луна как таковая не имеет специально обученного алгоритма. Иначе откуда у меня были бы снимки, на которых Луна не так уж хороша и это де-факто брак?

И расскажите, во что верите вы. Луна поддельная? Важно ли это для вас?