Современные компьютеры — штука мощная, но иногда они работают не так, как нам хотелось бы. Представьте себе, что вам нужно распознать лицо друга на фотографии или понять, что говорит человек с акцентом. Для вас это пара секунд — мозг просто «щелкает» и выдает результат. А вот традиционному компьютеру для таких задач приходится проделывать кучу расчетов, обрабатывать гигабайты данных и тратить массу времени.

Ранее мы уже разбирались с квантовыми компьютерами, которые работают совершенно иначе, чем привычные нам процессоры. Спасибо за ваши комментарии к той статье — сделал для себя пометки. Как вы понимаете, тема сложная, и иногда могут быть неточности.

Но квантовые технологии — это не единственная «космическая» ветвь развития вычислительной техники. Сегодня я предлагаю заглянуть в еще одно перспективное направление — нейроморфные компьютеры. Эти машины созданы по образу и подобию человеческого мозга и могут кардинально изменить подход к вычислениям. Давайте разбираться, что это за зверь и почему он может стать будущим искусственного интеллекта.

Table of Contents

- Почему обычные компьютеры не всегда эффективны?

- Что такое нейроморфные компьютеры и зачем они нужны?

- Как работают обычные компьютеры?

- Что такое нейроморфные компьютеры?

- Искусственные нейроны и синапсы

- Аппаратная реализация: чипы, мемристоры и другие технологии

- Оптические нейроморфные системы — вычисления со скоростью света

- Как выглядит нейроморфный компьютер?

- Где можно применять нейроморфные технологии?

- Какие проблемы и перспективы?

- Возможное будущее нейроморфных компьютеров

- Нейроморфные vs. квантовые: в чем разница?

- Заключение

Почему обычные компьютеры не всегда эффективны?

Классические компьютеры работают по четким инструкциям: бери данные — обрабатывай их по заданному алгоритму — выдавай результат. Они хороши, когда нужно посчитать что-то строгое и точное, например, сумму цифр в таблице или построить маршрут в навигаторе.

Но когда дело касается задач, требующих гибкости и адаптации, они начинают буксовать. Вот представьте: вы показываете компьютеру фотку собаки и говорите: «Определи, что это». Если в базе нет точно такой же собаки под таким же углом, у него могут начаться проблемы. Он не «видит» собаку так, как человек, а сравнивает пиксели, пытаясь найти совпадение. В итоге процесс идет долго, требует кучи ресурсов и, что самое неприятное, результат может быть ошибочным.

А теперь сравните это с вашим мозгом. Вам достаточно взглянуть на изображение, и вы сразу понимаете: «Ну это же собака!». Более того, даже если она в темных очках или нарисована в мультяшном стиле, вы все равно узнаете ее. Вот это и есть главное отличие — человеческий мозг не считает пиксели, а воспринимает информацию целостно, быстро адаптируется и обучается сам по себе.

Именно поэтому ученые задумались: а что, если компьютеры могли бы работать похожим образом? Так и появилась идея нейроморфных компьютеров.

Что такое нейроморфные компьютеры и зачем они нужны?

Нейроморфные компьютеры — это системы, которые пытаются подражать работе человеческого мозга. Вместо того, чтобы тупо перебирать алгоритмы и делать миллионы расчетов, они обрабатывают информацию более «интуитивно», как это делают нейроны в голове.

Если говорить простым языком, то обычный компьютер — это калькулятор, который делает вычисления очень быстро, но без понимания. А нейроморфный компьютер — это нечто вроде электронного мозга, который учится, запоминает и может адаптироваться.

Зачем они нужны?

- Распознавание речи и текста. Классические компьютеры понимают речь, если она четкая и произносится как в учебниках. Нейроморфные системы могут обучаться и распознавать речь даже с акцентом или в шумной среде;

- Робототехника. Представьте себе робота, который не просто выполняет программы, а действительно учится взаимодействовать с окружающим миром;

- Автопилоты. Машины на автопилоте должны мгновенно принимать решения, анализируя окружающую обстановку, а не просто следовать зашитым в них алгоритмам.

По сути, нейроморфные компьютеры — это следующий шаг к созданию настоящего искусственного интеллекта, который не просто выполняет команды, а думает как живое существо.

Как работают обычные компьютеры?

Чтобы понять, чем нейроморфные компьютеры отличаются от обычных, давайте разберемся, как вообще работают наши привычные «железки».

Если совсем упрощенно, традиционный компьютер — это супербыстрый счетовод. Он умеет брать данные, выполнять с ними операции (складывать, умножать, сравнивать) и сохранять результаты. За это отвечает процессор — его можно представить как мозг компьютера, но… очень специфический.

Процессор работает по жестким правилам:

- Выборка данных и инструкций;

- Обработка данных;

- Сохранение результата.

Вся его работа строится на математике и логике. Например, если компьютер видит команду «5 + 3», он точно знает, что делать: берет цифры, складывает и выдает «8».

Теперь представьте, что перед компьютером не просто числа, а что-то более сложное, например, изображение кошки. Компьютер не «видит» кошку так, как это делает человек. Для него изображение — это массив чисел (пикселей), где каждый пиксель описывается своим цветом (например, в формате RGB) и координатами. Чтобы распознать, что на изображении именно кошка, компьютер использует сложные алгоритмы, такие как нейронные сети. Эти алгоритмы анализируют изображение, выделяя важные признаки (например, края, формы, текстуры), и на их основе делают выводы.

Теперь добавим сюда память. Компьютеру нужно где-то хранить все промежуточные результаты, а также быстро получать доступ к данным для обработки. Для этого используется иерархия памяти: кэш-память процессора (L1, L2, L3), оперативная память (RAM) и другие уровни. Даже оперативная память работает не мгновенно, и процессору приходится перемещать данные между разными уровнями памяти. Это может замедлять работу.

Классические компьютеры — мощные и точные, но они лучше всего справляются с задачами, где нужны четкие инструкции и предсказуемые вычисления. Когда дело доходит до адаптации к реальному миру, их возможности ограничены.

Именно поэтому ученые задумались: а что, если создать машину, которая будет работать не как калькулятор, а как мозг? Так появились нейроморфные компьютеры, которые имитируют структуру и принципы работы мозга, позволяя эффективно решать задачи, связанные с обучением и адаптацией. И вот тут начинается самое интересное.

Что такое нейроморфные компьютеры?

Наш мозг — невероятно крутая штука. В нем есть нейроны — крошечные клетки, которые обмениваются сигналами через синапсы («мостики» между нейронами в мозге, через которые передаются сигналы). Когда вы что-то учите или запоминаете, связи между нейронами перестраиваются, усиливаются или ослабевают. Именно благодаря этому мозг адаптируется и развивается. Представьте, что нейроны — это люди, которые передают друг другу записки с важной информацией. А синапсы — это столы между ними. Если два человека часто обмениваются записками, стол между ними становится шире и удобнее. Если записки приходят редко — стол постепенно исчезает.

Нейроморфные компьютеры работают по схожему принципу. Вместо стандартных процессоров и памяти в них используются искусственные нейроны и синапсы, которые передают сигналы и меняют свою структуру в процессе работы. То есть такая система может обучаться, запоминать информацию и адаптироваться, а не просто выполнять инструкции по шаблону.

Искусственные нейроны и синапсы

Как мы уже говорили, в мозге есть нейроны — клетки, которые передают сигналы через синапсы. Они соединяются между собой, создавая сложные сети. Чем чаще проходит сигнал по определенному пути, тем сильнее становится связь — так мы учимся и запоминаем.

В нейроморфных компьютерах эту систему воссоздали с помощью электроники. Искусственные нейроны (чаще всего строятся на основе транзисторов) выполняют функцию вычислительных элементов, а искусственные синапсы (чаще всего реализуются с помощью мемристоров) регулируют силу связи между ними. Если какой-то маршрут сигналов используется чаще, он становится «привычным» для системы, и она лучше обрабатывает подобные данные в будущем.

Аппаратная реализация: чипы, мемристоры и другие технологии

Нейроморфные компьютеры — это не просто классические процессоры с новой прошивкой. Это абсолютно другая архитектура, которая создана для того, чтобы имитировать работу мозга. Для этого нужны специальные компоненты, которые работают не как стандартные чипы, а как искусственные нейросети. Давайте разберемся, из чего же состоят эти технологии.

1. Нейроморфные чипы — мозг в микросхеме

Если обычные процессоры можно сравнить с заводом, где все процессы идут строго по инструкциям, то нейроморфные чипы больше похожи на живую экосистему, где элементы взаимодействуют и адаптируются. Внутри таких чипов находятся тысячи, а иногда и миллионы искусственных нейронов, которые соединены между собой, имитируя структуру биологических нейронных сетей (это миниатюрные электронные схемы, собранные из транзисторов или мемристоров).

В отличие от традиционных процессоров, которые выполняют команды последовательно или параллельно в ограниченных масштабах, нейроморфные чипы обрабатывают информацию массово-параллельно. Это делает их особенно эффективными в задачах, связанных с машинным обучением, анализом изображений и речью, хотя они и не универсальны, как традиционные процессоры.

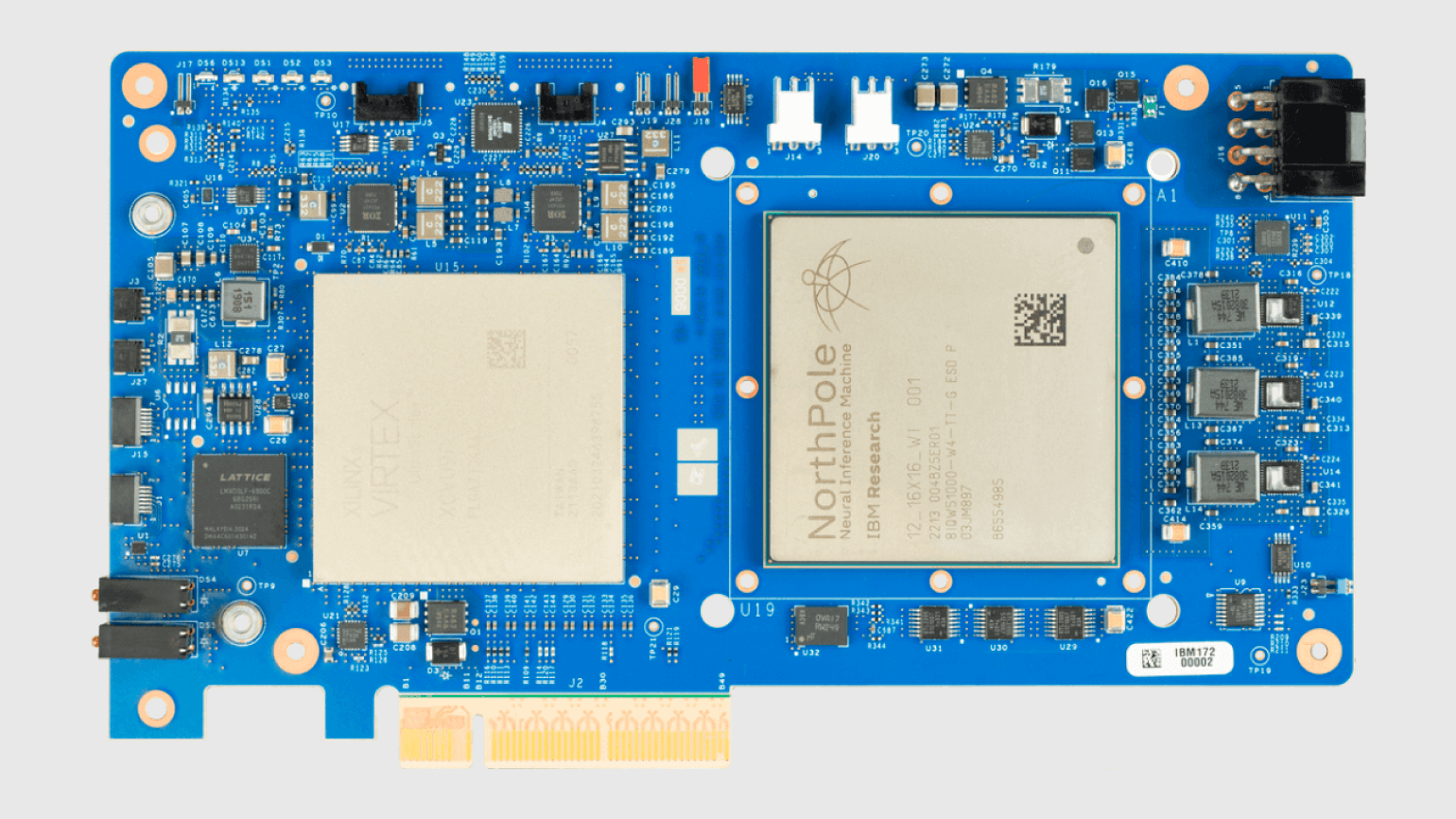

Примеры современных чипов:

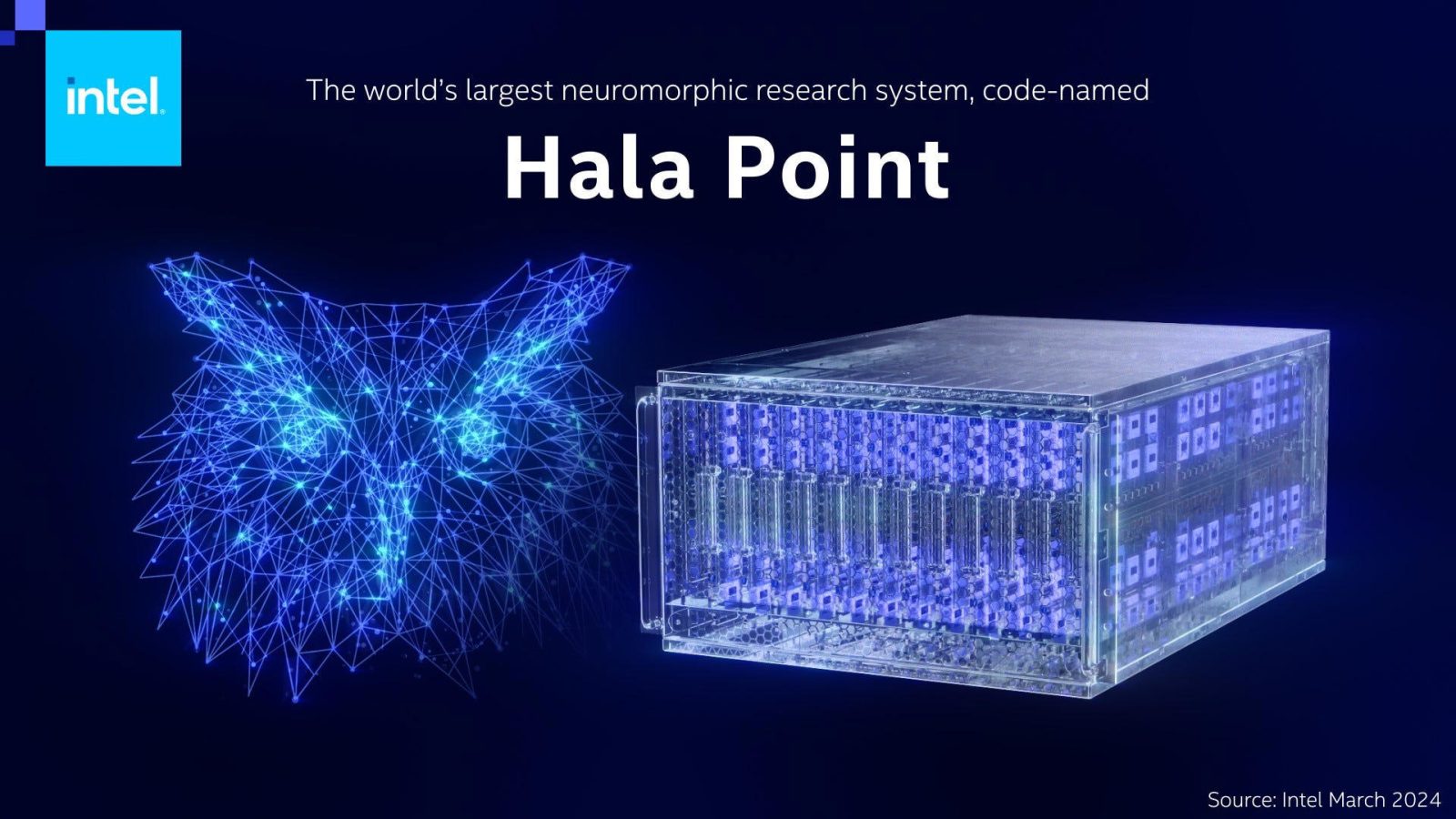

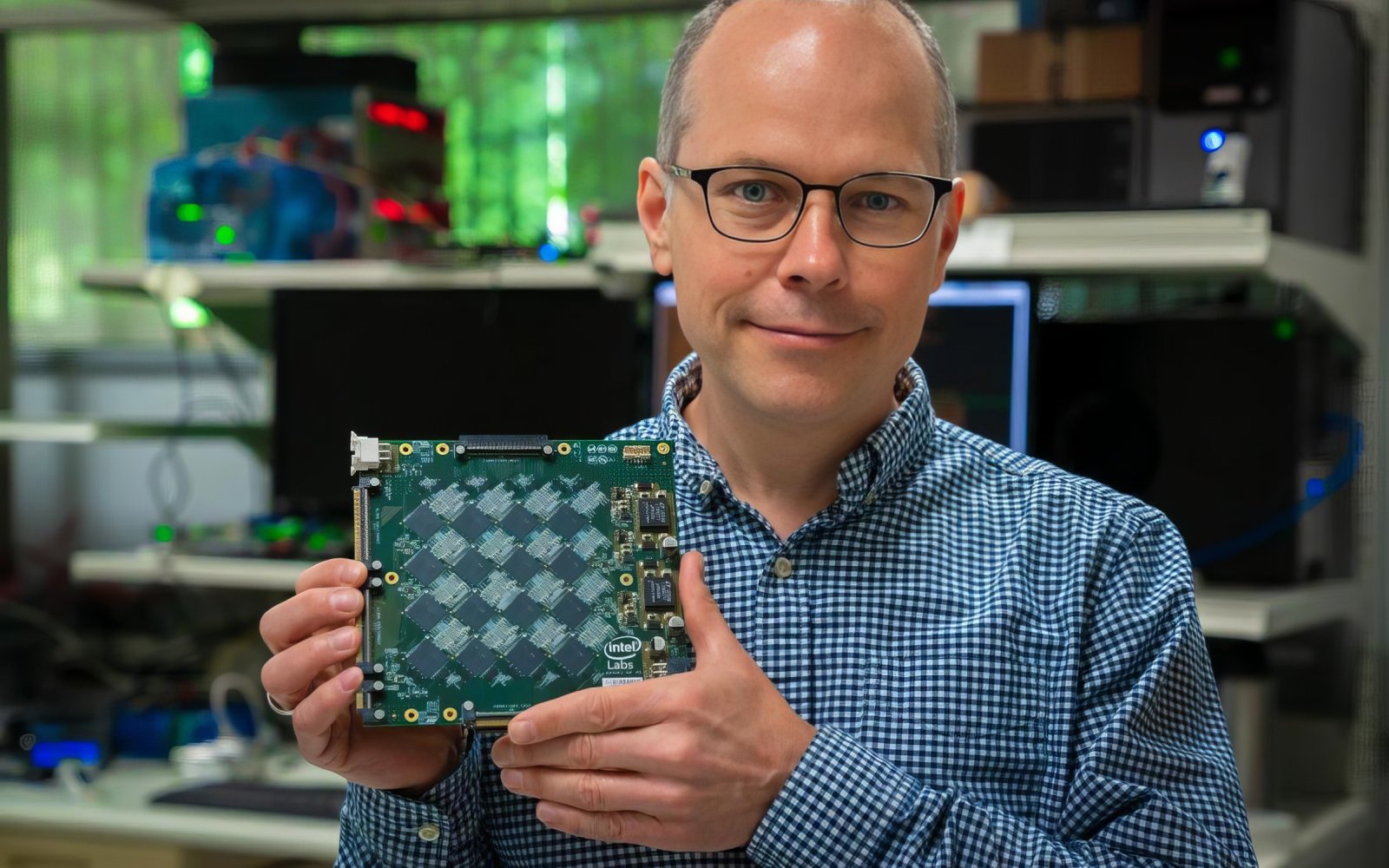

- Loihi 2 (2021 год) и новейший HalaPoint (2024 год) от Intel — умеет обучаться прямо во время работы, без дополнительного программирования. Например, может самостоятельно адаптироваться к почерку человека;

- DeepSouth — проект реализуется командой исследователей из Международного центра нейроморфных систем (International Centre for Neuromorphic Systems — ICNS) при Университете Западного Сиднея в Австралии;

- «Алтай». Совместная разработка компаний «Мотив-НТ» и «Лаборатории Касперского».

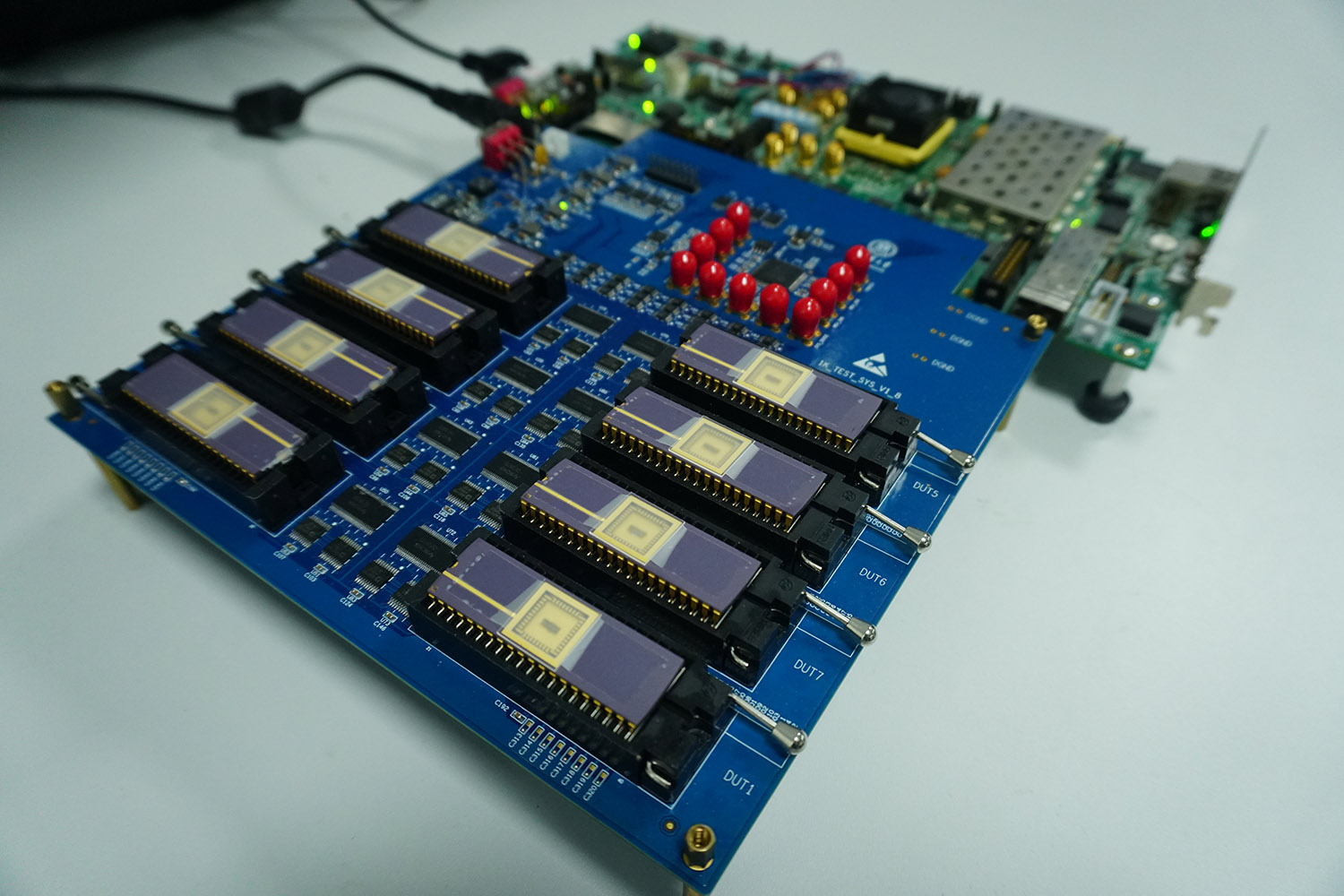

Примеры чипов, показанных ранее:

- TrueNorth от IBM (2014 год) — содержит 1 миллион искусственных нейронов и потребляет в 100 тысяч раз меньше энергии, чем обычные процессоры;

- SpiNNaker от Манчестерского университета (2018 год) — способен имитировать работу 1% человеческого мозга, что уже само по себе звучит впечатляюще.

2. Мемристоры — искусственные синапсы

Представьте, что у вас есть доска, на которой можно писать и стирать, но с одним интересным свойством: чем сильнее вы нажимаете, тем ярче и дольше остается надпись. Вот так же работают мемристоры.

Это специальный тип электронного компонента, внутри которого находятся два слоя материала. Под действием электрического тока ионы или вакансии перемещаются между слоями, изменяя сопротивление устройства. Когда через мемристор проходит ток, он «запоминает» свое состояние, сохраняя его даже после отключения питания.

В отличие от обычной компьютерной памяти, которая хранит только «0» и «1», мемристоры могут плавно изменять свое сопротивление. Это позволяет им имитировать работу биологических синапсов, что делает их ключевым элементом в нейроморфных вычислениях.

Почему это круто:

- Мемристоры могут «запоминать» информацию даже после отключения питания. Это делает их энергонезависимыми, в отличие от оперативной памяти (RAM), которая теряет данные при отключении питания;

- Они позволяют чипу работать без постоянного обращения к внешней памяти, что экономит энергию. Мемристоры могут использоваться как для хранения данных, так и для вычислений (in-memory computing), что сокращает энергозатраты на передачу данных между процессором и памятью;

- Чем больше система использует определенные связи, тем сильнее они становятся, имитируя процесс обучения мозга. Мемристоры могут изменять свое сопротивление в зависимости от активности, что делает их полезными для создания нейроморфных систем, имитирующих работу биологических нейронных сетей.

Оптические нейроморфные системы — вычисления со скоростью света

Если электроника кажется вам навороченной, представьте себе компьютер, в котором нет электричества. Вместо этого — потоки света, которые передают данные между искусственными нейронами со скоростью фотона.

Вместо обычных проводов и транзисторов используются световые сигналы, которые проходят через специальные чипы с миниатюрными зеркалами и линзами.

Такие системы могут выполнять миллионы операций одновременно, потому что световые сигналы не мешают друг другу, в отличие от электрических импульсов.

Это снижает энергопотребление до минимума, ведь не нужно преодолевать сопротивление проводников и нагреваться, как в обычных процессорах.

Оптические системы пока находятся в стадии разработки, но в будущем они могут стать основой для мощнейших нейроморфных суперкомпьютеров. В частности, они идеально подходят для обработки огромных массивов данных, например, в медицинской диагностике или климатическом моделировании.

Как выглядит нейроморфный компьютер?

Внешне он может быть разным, все зависит от масштаба. На самом базовом уровне нейроморфный компьютер — это специализированный чип, который содержит миллионы искусственных нейронов и синапсов. Физически он выглядит как обычная микросхема, но внутри устроен совершенно иначе.

Нейроморфные чипы часто устанавливаются на платы, которые подключаются к компьютеру или используются как часть более крупной системы.

Для более сложных задач нейроморфные компьютеры могут состоять из множества плат, объединенных в одну систему. Такие системы могут занимать целые серверные стойки.

В исследовательских лабораториях нейроморфные компьютеры часто выглядят как наборы экспериментальных плат, проводов и измерительного оборудования. Они могут быть собраны вручную и не иметь коммерческого дизайна.

Где можно применять нейроморфные технологии?

Нейроморфные компьютеры пока не стоят у вас на столе, но их уже активно тестируют. Они идеальны там, где требуются обучение, адаптация и быстрая обработка сложных данных, особенно в условиях ограниченной мощности и энергии.

1. Искусственный интеллект и машинное обучение

Обычные компьютеры учат нейросети по жестким алгоритмам, используя мощные серверы. Это требует много энергии, памяти и времени. Нейроморфные системы могут обучаться на лету, прямо в процессе работы, и делать это гораздо быстрее и эффективнее.

Где можно применить?

- Чат-боты и голосовые помощники (Алиса, Siri, Google Assistant и т.д.) могут стать умнее и быстрее благодаря нейроморфным чипам, которые улучшают способность понимать речь;

- Предсказательная аналитика — финансовые компании тестируют нейроморфные системы для анализa биржевых данных и прогнозирования рынков;

- Медицинская диагностика — нейроморфные ИИ могут помогать врачам определять рак на ранних стадиях и анализировать огромные объемы медицинских изображений в реальном времени.

2. Робототехника и автономные системы

Обычные роботы выполняют четко прописанные команды, а вот адаптироваться к изменениям им трудно. Нейроморфные системы позволяют роботам обучаться в процессе работы, что делает их гибче и умнее.

Где можно применить?

- Автопилоты и беспилотники — такие системы могут быстрее анализировать дорожную ситуацию, прогнозировать поведение пешеходов и других машин, а значит, делать вождение безопаснее;

- Роботы-помощники — в промышленных и бытовых роботах нейроморфные чипы позволят им быстрее распознавать голосовые команды и адаптироваться к окружению;

- Исследовательские роботы — в космосе или на глубоководных аппаратах нейроморфные технологии позволяют машинам самостоятельно принимать решения, снижая зависимость от операторов.

3. Распознавание образов, обработка данных

Чем больше данных, тем сложнее их анализировать. Нейроморфные системы параллельно обрабатывают информацию, поэтому они отлично подходят для задач, связанных с анализом изображений, видео и других массивов данных.

Где можно применить?

- Камеры безопасности — могут распознавать лица и поведение в реальном времени, например, на вокзалах и в аэропортах;

- Медицинские системы — анализировать рентгеновские снимки и МРТ быстрее врачей, помогая находить аномалии;

- Генетические исследования — помочь расшифровывать ДНК в разы быстрее, чем традиционные алгоритмы.

Какие проблемы и перспективы?

Нейроморфные компьютеры звучат как будущее, которое уже наступило, но на самом деле они пока в стадии активного развития. У технологии есть крутые перспективы, но и серьезные препятствия, которые мешают ей стать массовой.

- Сложность разработки

Разработка нейроморфных компьютеров — это сложный процесс, потому что они работают иначе, чем традиционные вычислительные системы. Обычные компьютеры создавались десятилетиями, и программирование под них давно стало понятным и стандартизированным. В случае с нейроморфными системами все иначе: их архитектура вдохновлена мозгом, а значит, требует совершенно нового подхода.

Одна из главных трудностей — необходимость разработки новых инструментов и подходов для программирования. Большая часть современного ПО заточена под классические процессоры, а для нейроморфных систем требуются специализированные алгоритмы, которые могут обучаться и адаптироваться подобно живым нейросетям. Вместо создания полностью новых языков программирования часто используются специализированные фреймворки и библиотеки, такие как NEST, PyNN или Intel Nx SDK.

Кроме того, традиционные компьютеры основаны на четкой цифровой логике: они работают с бинарными данными (0 и 1) и выполняют операции в строго определенном порядке. В нейроморфных системах все сложнее: нейроны и синапсы взаимодействуют нелинейно, а их поведение может быть вероятностным. Это делает прогнозирование и отладку таких систем более сложной задачей, но именно эти свойства позволяют им эффективно решать задачи, связанные с обучением и адаптацией.

Еще одна проблема — отсутствие стандартов. Пока что разные компании разрабатывают собственные версии нейроморфных чипов, и каждая из них использует свою архитектуру. Например, у Intel есть Loihi, у IBM — NortPole, а у «Мотив-НТ» будет «Алтай». Пока неясно, какой формат станет основным, а это затрудняет широкое распространение технологии.

Разработка нейроморфных компьютеров требует принципиально иного подхода по сравнению с традиционным программированием. Если программист, привыкший к четким инструкциям и последовательным вычислениям, переходит к работе с нейроморфными системами, ему приходится иметь дело с процессами обучения, адаптации и нелинейного взаимодействия компонентов. Это больше похоже на настройку сложной динамической системы, чем на написание классического программного кода. Однако важно понимать, что нейроморфные компьютеры — это не «живые организмы», а электронные устройства, которые имитируют некоторые аспекты работы мозга, оставаясь при этом управляемыми и предсказуемыми в рамках заданных параметров.

- Ограниченность технологий на данный момент

Хотя прототипы нейроморфных компьютеров уже существуют, они пока далеки от возможностей человеческого мозга. Одно из главных ограничений — недостаточное количество нейронов. Например, чип HalaPoint от Intel содержит всего 1,15 миллиарда нейронов, тогда как в мозге человека их около 80 миллиардов. Разница огромная, и современные технологии пока не позволяют создать настолько сложную систему.

Еще одна проблема — сложности с массовым производством. Нейроморфные процессоры устроены сложнее традиционных, а технологии, такие как мемристоры, которые должны имитировать работу синапсов, пока не доведены до совершенства. Производственный процесс таких чипов требует новых материалов, методов сборки и тестирования, что значительно замедляет их распространение.

Кроме того, нейроморфные компьютеры остаются дорогими. Сейчас их разрабатывают в основном научные лаборатории, а массовое производство таких систем требует огромных вложений. Пока что это скорее экспериментальная технология, чем готовый к коммерческому использованию продукт.

Если провести аналогию, то ситуация похожа на попытку создать копию человеческого мозга, имея в распоряжении лишь калькулятор. Калькулятор умеет складывать и вычитать, но до полноценного мышления ему еще очень далеко. Точно так же нейроморфные процессоры пока обладают лишь частью возможностей биологического мозга и требуют серьезных доработок, прежде чем смогут сравниться с ним по эффективности.

Возможное будущее нейроморфных компьютеров

Несмотря на текущие сложности, у нейроморфных компьютеров огромные перспективы. В будущем они могут привести к появлению искусственного интеллекта совершенно нового уровня. Вместо заранее прописанных алгоритмов такие системы смогут самостоятельно обучаться, понимать контекст и принимать сложные решения, как это делает человеческий мозг. Это позволит создать по-настоящему умные технологии, которые не просто выполняют команды, а адаптируются к окружающей среде.

Одно из ключевых направлений развития — робототехника. Нейроморфные системы дадут роботам возможность обучаться в реальном времени, анализировать ситуацию, взаимодействовать с людьми и осваивать новые навыки, например, учиться ходить или работать с разными объектами. Это особенно важно для автономных машин, которые должны адаптироваться к постоянно меняющимся условиям.

Еще одна важная перспектива — миниатюризация и повышение энергоэффективности. Сегодня для работы сложных нейросетей требуются мощные серверы и огромные вычислительные ресурсы. В будущем же нейроморфные процессоры смогут обучаться прямо внутри устройства, будь то смартфон, бытовая техника или автомобиль. Это позволит создать более умные и автономные системы, которые не зависят от подключения к интернету или облачных серверов.

Наконец, появление нейроморфных компьютеров приведет к созданию нового типа вычислительных систем. Традиционные процессоры не исчезнут, но рядом с ними появятся специализированные системы, способные выполнять задачи, требующие сложного анализа, обучения и адаптации. Эти системы, основанные на нейроморфных технологиях, смогут эффективно решать задачи, связанные с распознаванием образов, обработкой естественного языка и принятием решений, что сделает их незаменимыми помощниками в областях, где требуется «интеллектуальный» подход.

Нейроморфные vs. квантовые: в чем разница?

Нейроморфные и квантовые компьютеры — это две перспективные технологии будущего, но они решают задачи принципиально по-разному. Нейроморфные системы имитируют работу мозга: они используют искусственные нейроны и синапсы, которые могут обучаться и адаптироваться. Их основное преимущество — эффективная обработка задач, связанных с распознаванием образов, обучением и принятием решений.

Квантовые компьютеры, напротив, используют законы квантовой механики. Они оперируют кубитами, которые могут находиться в суперпозиции состояний, что позволяет им решать определенные задачи на порядок быстрее, чем традиционным компьютерам. Их сила — в сложных математических вычислениях, криптографии и моделировании молекул.

Если провести аналогию, нейроморфные компьютеры — это как мозг, который учится и анализирует информацию, а квантовые — как мощный вычислительный инструмент, способный мгновенно просчитывать множество вариантов. Они не конкурируют, а дополняют друг друга и в будущем могут быть объединены в гибридные системы для решения еще более сложных задач.

О нейроморфном процессоре «Алтай»

Я связался с представителями «Мотив-НТ» для получения комментария по поводу их процессоров «Алтай»:

« — Продолжаются ли работы над этим проектом и когда можно будет ожидать появления новой версии «Алтая»?

К концу 2025 года — началу 2026-го мы планируем получить уже третье поколение прототипа. Микропроцессор будет иметь принципиально новую архитектуру, но сохранит событийный принцип работы, за счет чего будет решать как задачи искусственного интеллекта (анализ данных, распознавание образов, обучение на потоках данных и принятие решений), так и задачи общего назначения (вычисления, фильтрация данных, потоковая обработка). Кроме того, заложена возможность сборки модулей в вертикальный стек, что позволит подключать чип через USB-порт как стандартные флеш-накопители и увеличивать вычислительные возможности существующих устройств. И, пожалуй, самое важное изменение – на новой версии можно реализовывать алгоритмы обучения нейронных сетей.

— Буду признателен за информацию о ваших планах на будущее.

Технология находится на стадии созревания, и мы изучаем различные варианты интеграции в конечные устройства. Диапазон применения чипа практически не ограничен: микропроцессор будет одинаково эффективен в IoT, робототехнике, беспилотном транспорте и дата-центрах. На данном этапе рассматриваем стратегическое партнерство с технологическими гигантами, заинтересованными в радикальном снижении энергозатрат на решение задач, связанных с искусственным интеллектом».

Заключение

Нейроморфные компьютеры — это шаг в будущее, где техника станет не просто быстрой, а по-настоящему умной. Они смогут учиться, адаптироваться и решать задачи, которые обычным процессорам не под силу. Искусственный интеллект станет ближе к человеку, роботы — самостоятельнее, а устройства — умнее и энергоэффективнее.

Появятся ли они в нашей жизни прямо сейчас? Пока нет. Технология еще в разработке. Возможно, через 10–20 лет нейроморфные чипы начнут встраивать в смартфоны, бытовую технику и автомобили, чтобы они лучше понимали нас. А пока остается следить за прогрессом и готовиться к тому, что компьютеры будущего будут работать не как машины, а почти как мозг.

Так какой тип компьютеров впечатляет больше — тот, что учится как мозг, или тот, что считает быстрее всех?