По материалам The Verge

Во вторник OpenAI анонсировала GPT-4, свою языковую модель нового поколения. Хотя компания предупредила, что различия между GPT-4 и его предшественниками «незаметны» с точки зрения обывателя, система обладает множеством новых возможностей. Например, она может обрабатывать изображения, а OpenAI говорит, что она в целом лучше справляется с творческими заданиями и решением задач.

Проверить эти утверждения непросто. Модели ИИ в целом чрезвычайно сложны, а такие системы, как GPT-4, спорадически растут и обладают множеством функций, скрытых и пока неизвестных возможностей. Проверка фактов также составляет проблему. Например, когда GPT-4 уверенно сообщает вам, что он создал новое химическое соединение, вы не узнаете, правда ли это, пока не спросите у нескольких настоящих химиков (впрочем, когда это мешало крикунам из Твиттера*) Как заявляет OpenAI в своем техническом отчете, самым большим ограничением GPT-4 является то, что он «галлюцинирует», выдавая информацию (то есть выдумывает ее) и часто «уверенно ошибается в своих прогнозах».

Невзирая на эти предостережения, GPT-4 определенно интересен с технической точки зрения и уже интегрируется в массовые продукты. Итак, чтобы понять, что нового появилось, издание The Verge собрало несколько примеров его умений и способностей из новостей, Twitter* и от самой OpenAI, а также провело собственные тесты. И вот что получилось.

Может обрабатывать изображения вместе с текстом

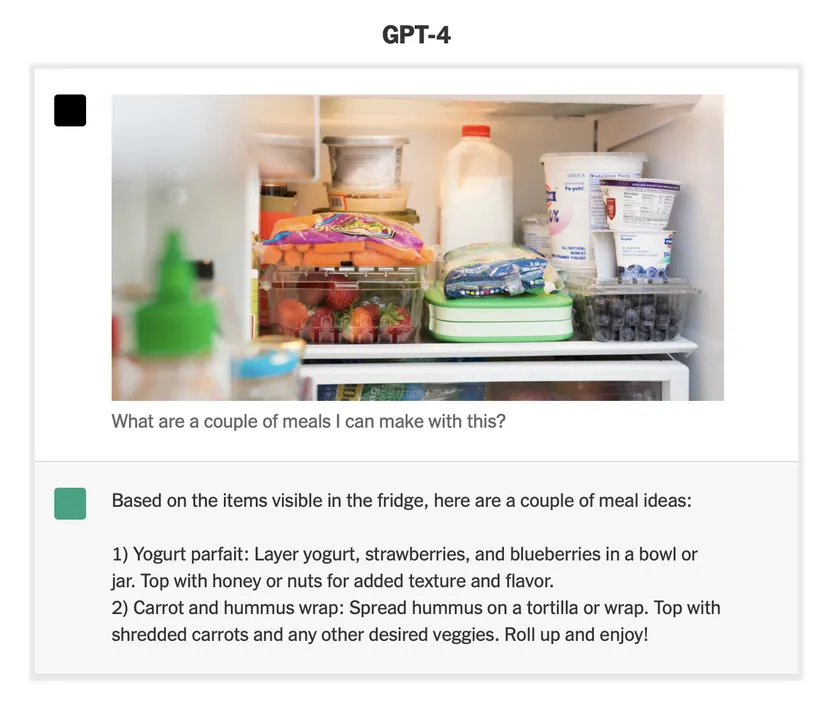

Как было сказано выше, это самое большое практическое отличие GPT-4 от его предшественников. Система является мультимодальной, то есть она может анализировать как изображения, так и текст, тогда как GPT-3.5 может обрабатывать только текст. Это означает, что GPT-4 умеет анализировать содержимое изображения и связывать эту информацию с письменным вопросом (хотя и не может генерировать изображения, как DALL-E, Midjourney или Stable Diffusion.)

Что это значит на практике? В New York Times приводится пример, в котором GPT-4 показывают содержимое холодильника и спрашивают, какие блюда можно приготовить из этих ингредиентов. Разумеется, основываясь на картинке, GPT-4 предлагает несколько примеров как пикантных, так и сладких блюд. Однако стоит отметить, что одно из этих предложений — ролл — требует ингредиента, которого, кажется, там нет: тортильи.

Есть много других способов применения для этой функции. В демо-ролике от OpenAI компания показала, как GPT-4 может создавать код для веб-сайта, например, на основе нарисованного от руки эскиза. OpenAI также работает со стартапом Be My Eyes, который использует распознавание объектов и услуги добровольцев, чтобы помочь людям с проблемами зрения, с целью улучшения приложения компании за счет GPT-4.

Такую функциональность нельзя назвать полностью уникальной (многие приложения предлагают базовое распознавание объектов, например, Apple Magnifier), но OpenAI утверждает, что GPT-4 может «генерировать тот же уровень контекста и понимания, что и человек-доброволец», объясняя окружающий мир пользователю, создавая выжимку из перегруженных веб-страниц или отвечая на вопросы о том, что он «видит». Функциональность еще не запущена, но «окажется в руках пользователей через несколько недель», как говорится в сообщении компании.

Есть и другая фирма, которая, по-видимому, также экспериментировала с возможностями распознавания изображений GPT-4. Джордан Сингер, основатель Diagram, написал в твиттере*, что компания работает над добавлением этой технологии в свои инструменты для дизайнеров на основе ИИ, чтобы внедрить такие функции, как чат-бот, который может комментировать проекты, и инструмент для помощи в создании проектов.

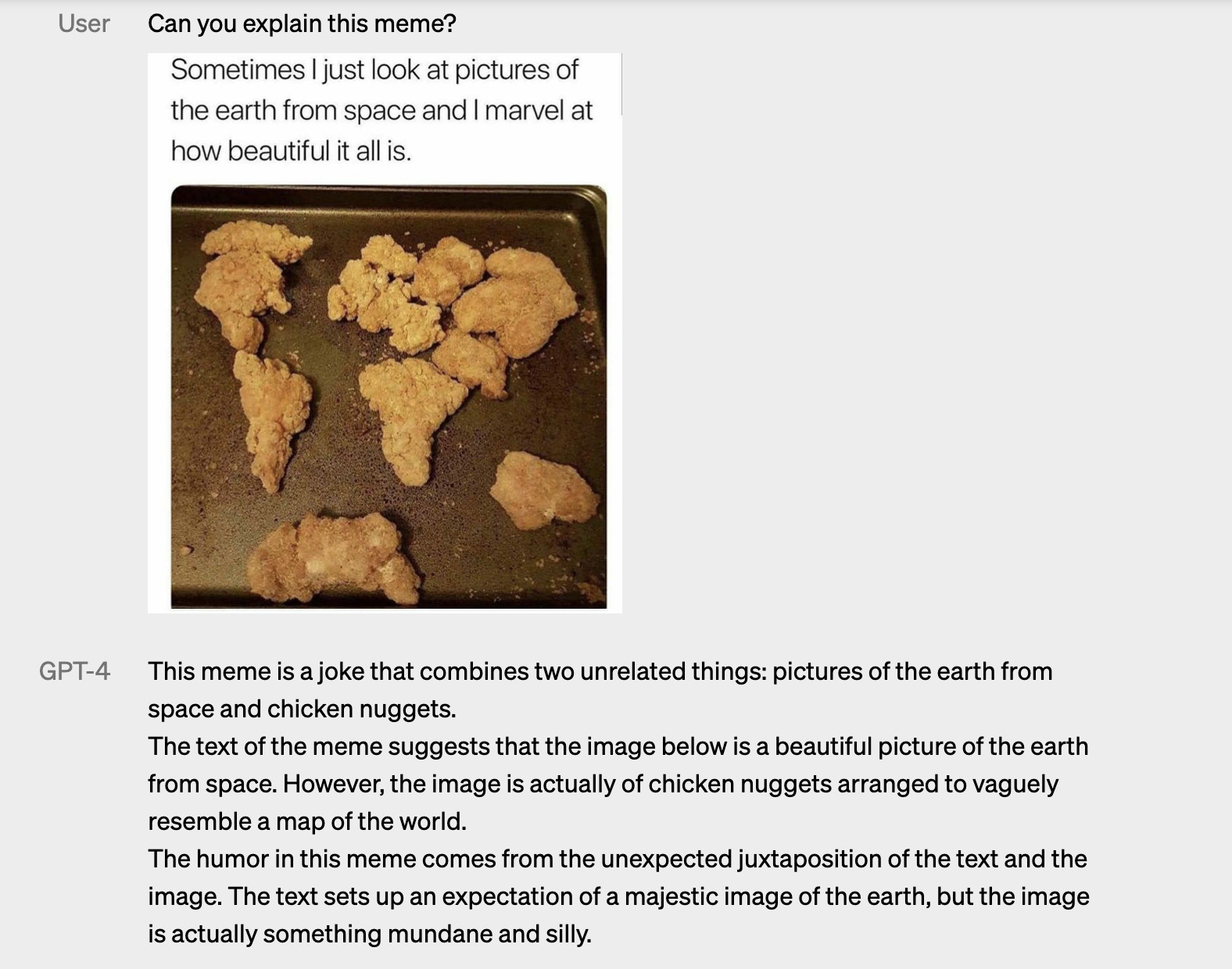

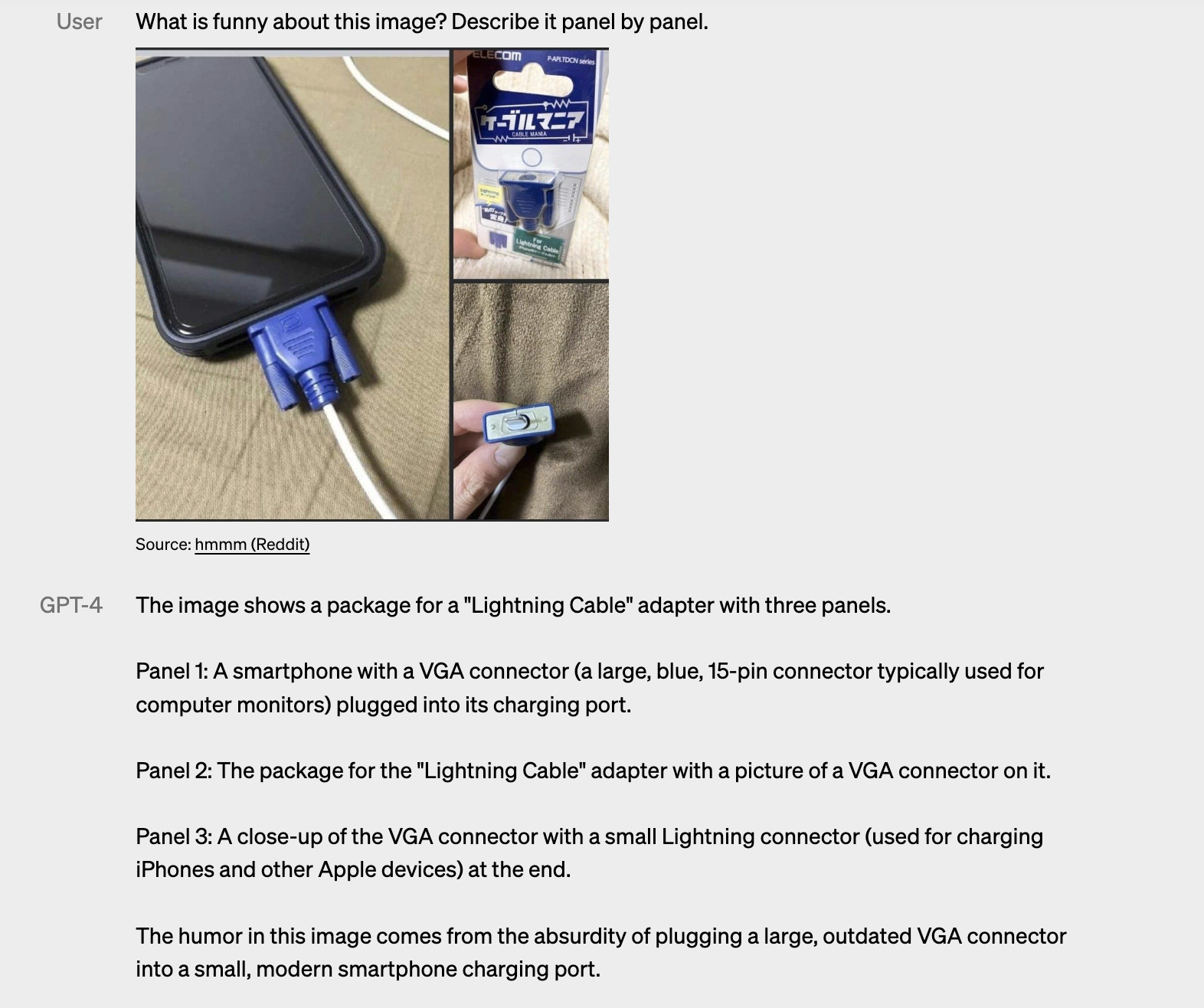

А еще, как показано на изображениях ниже, GPT-4 может объяснять смешные картинки.

Лучше играет словами

OpenAI говорит, что GPT-4 лучше справляется с задачами, требующими творческого подхода или сложных рассуждений. Это утверждение сложно оценить, но по результатам ряда тестов оно кажется вполне справедливым, хотя различия с предшественниками пока не поражают воображения.

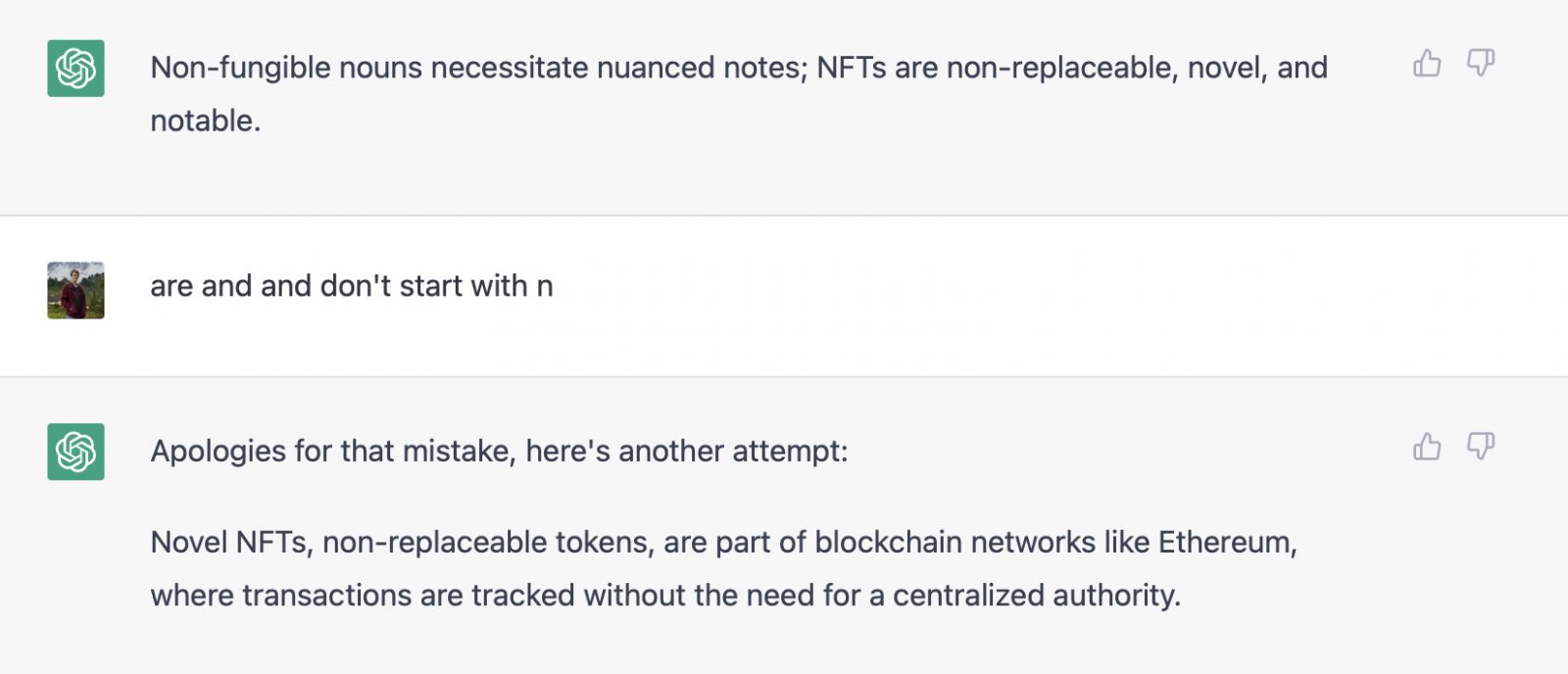

Во время демонстрации GPT-4 соучредитель OpenAI Грег Брокман попросил пересказать часть сообщения в блоге, используя только слова, начинающиеся с «g». Позже он попросил сделать то же самое, но с «a» и «q». «Мы добились успеха с [GPT-]4, но так и не достигли этого с 3.5», — сказал Брокман перед началом демонстрации. В видео от OpenAI GPT-4 отвечает достаточно понятным предложением, содержащим только одного слово, которое не начинается с буквы «g», а потом выдает полностью правильный вариант после того, как Брокман просит его исправиться. В то время как GPT-3, похоже, даже не пробовал выполнить задание.

В The Verge тоже поэкспериментировали с этой функцией, скормив ChatGPT текст для пересказа с использованием одних лишь слов, начинающихся с «n», и сравнили модели GPT-3.5 и 4 (в данном случае это были выдержки из статьи The Verge про NFT.) С первой попытки GPT-4 лучше справился с пересказом текста, но менее успешно следовал заданию.

Однако когда обе модели попросили исправить свои ошибки, GPT-3.5 практически сдался, тогда как GPT-4 выдал почти идеальный результат. Он по-прежнему включал предлог on, но, по правде говоря, его пропустили, когда просили исправить результат.

Также обе модели попросили превратить статью в стихотворение. И хотя читать стихи о NFT – это слишком больно, GPT-4 определенно справился с этой задачей лучше; его вирши выглядят значительно более сложными, в то время как GPT-3.5 развлекся на манер бездарного рэпера.

Может обрабатывать больше текста

Языковые модели ИИ всегда были ограничены объемом текста, который они могут хранить в своей кратковременной памяти (этот текст включает как вопрос пользователя, так и ответ системы). Но OpenAI резко расширила эти возможности для GPT-4. Теперь система может обрабатывать целые научные статьи и рассказы за один раз, что позволяет ей отвечать на более сложные вопросы и связывать между собой больше деталей в любом запросе.

Стоит отметить, что в GPT-4 нет счетчика символов или слов как такового, но ввод и вывод измеряются в единицах, известных как «токены». Этот процесс токенизации довольно сложен, но все, что нужно знать, это то, что токен равен примерно четырем символам и что 75 слов обычно составляют около 100 токенов.

Максимальное количество токенов, которые GPT-3.5-turbo может использовать в любом заданном запросе, составляет около 4000, это немногим более 3000 слов. Для сравнения, GPT-4 может обрабатывать около 32 000 токенов, что, по данным OpenAI, составляет около 25 000 слов. Компания говорит, что «все еще оптимизирует» модель для более длинных контекстов, но повышение этой планки означает, что модель должна разблокировать варианты использования, которые раньше было не так просто задействовать.

Может проходить тесты

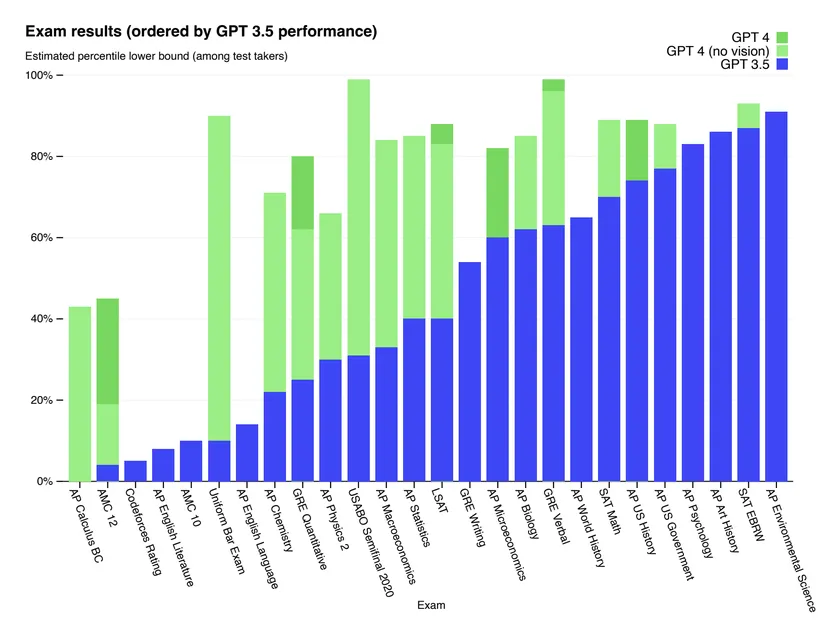

Одной из выдающихся метрик из технического отчета OpenAI по GPT-4 было прохождение им ряда стандартизированных тестов, включая экзамен на адвоката BAR, тест LSAT для поступающих в юридические вузы, тест GRE для поступления на любой последипломный курс в США, ряд модулей AP (курсы повышенной сложности в старших классах американской школы) и — по какой-то неизвестной, но очень забавной причине — вводные, сертификационные и продвинутые курсы сомелье от ассоциации Court of Master Sommeliers (только теоретическая часть!).

Вы можете увидеть сравнение результатов GPT-4 и GPT-3 в некоторых из этих тестов ниже. Обратите внимание, что GPT-4 довольно стабильно справляется с различными модулями AP, но по-прежнему мучается с теми, которые требуют более творческого подхода (например, экзамены по английскому языку и английской литературе).

Это впечатляющие результаты, особенно по сравнению с тем, чего могли бы добиться системы искусственного интеллекта прошлых лет, но для понимания достижений требуется некий контекст. Инженер и писатель Джошуа Леви лучше всего выразил это в своем твиттере*, описав логическое заблуждение, которому поддаются многие, глядя на эти результаты: «То, что программа может пройти тест, разработанный для людей, не означает, что она обладает теми же способностями, что и люди, прошедшие тот же тест».

Ученый-компьютерщик Мелани Митчелл подробно рассмотрела этот вопрос в своем блоге, в котором обсуждалась эффективность ChatGPT на различных экзаменах. Как указывает Митчелл, способность систем ИИ проходить эти тесты зависит от их способности сохранять и воспроизводить определенные типы структурированных знаний. Это не обязательно означает, что эти системы могут затем обобщать эти базовые знания. Другими словами: ИИ может быть наилучшим примером для обучения прохождению тестов.

Уже используется в массовых продуктах

В рамках анонса GPT-4 OpenAI поделилась несколькими историями об организациях, использующих эту модель. К ним относятся функция ИИ-репетитора, разрабатываемая Академией Кана, которая призвана помочь учащимся с написанием курсовой и снабжать учителей идеями для уроков, а также интеграция с Duolingo, которая обещает аналогичный интерактивный опыт обучения.

Предложение от Duolingo называется Duolingo Max и содержит две новые функции. Одна из них даст «простое объяснение» того, почему ваш ответ в упражнении был правильным или неправильным, и позволит вам запросить другие примеры или разъяснения. Другая — это режим «ролевой игры», который позволяет вам практиковаться в использовании языка в различных сценариях, например, заказывать кофе по-французски или планировать поход на испанском языке (в настоящее время это единственные два языка, доступные для этой функции.) Компания заявляет, что GPT-4 делает так, что «не будет двух одинаковых разговоров».

Другие компании используют GPT-4 в похожих сферах. Intercom объявила, что обновляет своего бота службы поддержки клиентов, используя эту модель, и пообещала, что система будет подключаться к документам поддержки бизнеса и отвечать на вопросы, в то время как платежный процессор Stripe будет использовать систему для внутренних целей, чтобы отвечать на вопросы сотрудников на основе своей технической документации.

Все последнее время работает в новом Bing

После объявления OpenAI Microsoft подтвердила, что модель, помогающая улучшить работу чата Bing, это на самом деле GPT-4. Что не является открытием. Microsoft уже заявляла, что использует «большую языковую модель OpenAI следующего поколения», но избегала называть ее GPT-4. В целом, теперь все, что мы знаем о взаимодействии с Bing, можно распространять и на GPT-4.

И, наконец…

Все еще делает ошибки

Очевидно, что чат Bing не идеален. Бот пытался газлайтить пользователей, делал глупые ошибки, а одного из журналистов спросил, не хочет ли он посмотреть фурри-порно. Отчасти все объясняется тем, как Microsoft внедрила GPT-4, но подобный опыт дает некоторое представление о том, как могут косячить чат-боты, построенные на этих языковых моделях.

Не то чтобы это было какой-то огромной проблемой. Это всего лишь напоминание о том, что все, кто занимается созданием и внедрением GPT-4 и других языковых моделей, уже в курсе: модели делают ошибки. Много ошибок. И любое применение, будь то в роли репетитора, продавца или программиста, должно сопровождаться предупреждением об этом огромными буквами.

Генеральный директор OpenAI Сэм Альтман говорил об этом в январе, когда его спросили о возможностях тогда еще не анонсированного GPT-4: «Люди жаждут разочароваться, и они разочаруются. Такой хайп… У нас нет настоящего AGI — а это то, чего от нас ждут».

Что ж, пока нет AGI, но есть система с более широкими возможностями, чем раньше. Теперь ждем самого главного: как именно и где она будет использоваться.