|

Новые модели:

Huawei Mate 30 Pro

Huawei Mate 30

iPhone 11

iPhone 11 Pro

iPhone 11 Pro Max

Samsung Galaxy Note10+

Samsung Galaxy Note10

Honor 8S

BQ 2818 ART XL+

BQ 1846 One Power

Xiaomi Mi A3

Huawei P smart Z

Huawei Y5 (2019)

Huawei P30 lite

Samsung Galaxy A80 (2019)

Новые обзоры:

Samsung Galaxy S10 Lite

Samsung A51

Panasonic TOUGHBOOK P-01K

HTC Wildfire E1 и E1 Plus

Redmi Note 8T

Vivo V17

Samsung A20s 2019

Oppo A9 2020

BQ Magic S

Philips S397

|

Искусственный интеллект. Морально-этическая сторона фантастики, ставшей реальностьюЭта статья задумывалась давно, но печальное событие прошлой недели ускорило ее выход и несколько изменило приоритеты. Двигавшийся на автопилоте автомобиль стал участником ДТП, в котором погиб человек. Это не первая жертва робота или ошибки автопилота, но первая, в которой робот не совершал ошибки, а также первая будничная. Такая, которая возникает не где-то там на заводе или на каком-то потенциально опасном производстве, а может произойти с абсолютно любым человеком в абсолютно любой день. Предварительные выводы дорожной полиции с полной уверенностью говорят, что причиной трагедии стал не робот, а нарушивший правила дорожного движения пешеход. Единственный вопрос, который остается открытым, – был бы человек-водитель в этом случае безопаснее для нарушителя? Впрочем, каждый может посмотреть видео с регистратора и переложить его на собственный опыт: Первые шаги, первые проблемыЭто первая запись в череде тех, на которых столкновение человека и робота ведет к гибели первого, но, к сожалению, не последняя. Потому что логика человеческого поведения никогда не станет машинной, а машины вряд ли когда-то приблизятся к интуитивному восприятию реальности на человеческом уровне. Причем не всегда это столкновение разной логики будет иметь фатальные последствия. Искусственный интеллект делает первые шаги, но уже в них со всей отчетливостью проявляются будущие конфликты миропонимания. Современное машинное обучение и алгоритмы ИИ стали очень хороши в обработке огромных объемов данных, но попытка научить машины интерпретировать и использовать эти данные быстро может привести к появлению ряда этических проблем.

ИИ компании Google не смог уверенно отличить негров от горилл, что вынудило инженеров запретить автоматическое присвоение тега «горилла» Когда мы применяем человеческие суждения, это неизбежно влияет на решения, которые выносит ИИ, на обработку данных и этику. Поэтому важно уделять особое внимание тому, чтобы наши предрассудки и неверные данные не вмешивались в машинное обучение и алгоритмы ИИ. Ряд известных примеров уже выявил потенциальные проблемы с предвзятыми данными или более спорными случаями применения машинного обучения. Алгоритмы неверно преувеличили уровень рецидивизма для чернокожих осужденных, работа с изображениями преувеличила стереотипные черты женщин. У Google случился печально известный инцидент с гориллами. Сейчас принимаются меры по купированию подобных ошибок, машине «подставляют плечо», в программный код добавляют очередной «костыль», чтобы негры не чувствовали себя обиженными за то, что компьютер не может отличить их от горилл. На нынешней стадии люди проверяют буквально каждое решение машины, но по мере роста количества решаемых задач это станет невозможным. Рост сложности ставящихся задач приведет к появлению комплексных решений, принятых на основе машинной обработки данных, когда человек физически не будет иметь возможности выявить ошибку, связанную с тем, что морально-этические дилеммы для машины – это просто набор нулей и единиц, которые когда-то были заданы одним из бессчетных тысяч программистов. И это не касаясь того аспекта, что на данный момент никто не предложил действенного средства объяснения машине универсального определения «что такое хорошо, а что такое плохо». Отделяем хорошее от плохогоПредставьте себе использование ИИ для решения проблемы распределения ограниченных ресурсов экстренного применения в городе. Системе придется не только вычислять оптимально возможное время реакции, количество необходимых ресурсов и определять приоритеты, но и переназначать приоритеты на ходу, а также перераспределять ресурсы между задачами. Это создает потребность в более контекстуальном и этичном решении. И вот проблема. Максимизировать число получивших помощь людей – прекрасная и понятная для ИИ градация «плохо/хорошо», однако машина будет пытаться перенасытить ресурсами происшествия с относительно низким риском, что повысит итоговый результат. Однако это заставит ее пренебречь происшествиями с меньшей вероятностью благоприятного исхода. Ужесточение критериев выбора даст обратный результат, и это в какой-то момент может парализовать систему, которая будет постоянно перенаправлять ресурсы на новые случаи с более высоким приоритетом, никогда не концентрируясь на решении проблем с более низким. ИИ потребуется принимать во внимание важность нюансов в каждом происшествии.

К сожалению, робот не может просто прочитать книжку. У него трудное детство, в котором вместо родителей – набор алгоритмов, придуманных обычными программистами На самом деле, подобные задачи уже стоят перед человечеством, и даже есть определенные алгоритмы решения таких задач, когда требуется жертвовать меньшим ради большего. Но на секунду представьте, что сюжет фильма «Спасение рядового Райана» переместился в далекое будущее, а приказ по поиску Джеймса Райана появился в результате компьютерной обработки данных. Или за сортировку поступающих в больницу пациентов стал отвечать не конкретный человек, а программа, которая не позволит начать лечение пациента, поскольку вероятность благоприятного исхода низкая. Ученик и учитель. Кто виноват?И это только половина проблемы. До момента, когда искусственный интеллект сможет создавать новые компьютерные программы и самостоятельно ставить перед собой задачи, пока далеко. Значит, все программы и алгоритмы – плод работы людей. Как мы знаем, с написанием действительно качественных программ по оптимизации распределения ресурсов системы дела обстоят не лучшим образом. Даже когда мы говорим о распределении ресурсов производительности чипсета между программами. Если по качеству комплектующих и материалов грань между А, В и С брендами стала размытой, то бездна между А и В по качеству софта чудовищна, а сравнение А и С и вовсе бессмысленно. Но если в телефоне крах приложения – это мелкая неприятность, то крах системы регулирования беспилотного транспорта в городе – прямой путь к катастрофе. И кто тут будет виноват? Машина? А если в ее коде будет найдена ошибка? Программист? А если этот баг мог проявиться при стечении только нескольких маловероятных событий? Или программист стал заложником ошибки в техническом задании? Как глубоко мы должны распутывать клубок и кого наказывать? На данный момент у человечества нет эффективных способов ответить на вопрос «чем нужно пожертвовать». Каждый раз принимается ситуативное решение, но для машинной логики такой вариант не подойдет. Поэтому прежде чем компьютерные системы смогут отвечать за что-то действительно важное, принимать самостоятельные решения на уровне, затрагивающем вопросы жизни и здоровья людей, придется усовершенствовать такую науку, как философия. Не дав самим себе ответа на вопрос, что считать добром, а что злом, мы не сможем научить машину отличать одно от другого. Однако нельзя сказать, что мы так уж далеки от получения этого ответа. Напротив, чем больше искусственный интеллект будет проникать в нашу жизнь, тем скорее вопрос из области чистой теории перейдет в практическую область.

Человек уже научился решать сложные морально-этические проблемы, руководствуясь доводами разума. Но в общем принципе всегда может быть исключение, что сложно объяснить машине Возможно, более важным станет прогресс не столько машины, сколько самого человека, живущего в окружении компьютеров, обладающих собственной волей и логикой. То, что для нас казалось фантастикой еще двадцать лет назад, для наших детей и внуков может быть объективной реальностью. Это будет чем-то вроде перехода от управления лошадью к управлению автомобилем. Чуть больше века назад принципы управления вторым были известны немногим, тогда как ничего более понятного, чем лошадь, придумать было невозможно, хотя для нас управление живым существом с собственным разумом, привычками и волей не идет ни в какое сравнение с простотой использования авто. Машины, которые умеют думатьНо решив проблему отделения хорошего от плохого и создав возможность заставить машинное обучение приходить к своим собственным решениям в области этики и к применению их в непредсказуемых ситуациях за счет программирования ключевых принципов, а в достижении результата положившись на опыт и итеративное обучение, мы порождаем новый кризис. В этом случае результаты машинной логики становятся менее предсказуемы и зависят от того, какие изначально были заложены правила. Если мы окончательно устраняем человека из этого уравнения, то получаем следующее: машины, которые умеют думать. Да, это не самая актуальная проблема, покуда не решен вопрос даже с теми машинами, которые умеют лишь анализировать в заданных пределах. Но полностью свободная воля и способность к творению в руках чуждого разума рисуют человеку совершенно апокалиптические картины, так что неплохо бы понять, к чему вообще готовиться и куда мы идем. «Терминатор», «Чужой. Завет» и добрая сотня других менее известных фантастических произведений убеждают нас в том, что как только искусственный интеллект выйдет за пределы трех законов робототехники, сформулированных Айзеком Азимовым еще в 1942 году, жить станет настолько плохо, что даже смертельно опасно. При этом оставаться в пределах правила, что «робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред», оказывается в ряде случаев невозможным.

Телесериал «Сотня» повествует о том, как неправильное определение морально-этических приоритетов для ИИ привело к гибели цивилизации. Пока это фантастика, но не такая далекая, как может показаться Проблема Первого закона робототехники в том, что он был придуман задолго до появления задач, которые действительно могут и должны решать компьютеры. На примере любой системы, призванной работать с потенциальным вредом человеку, хорошо видно, что этот закон делает задачу нерешаемой. Ограниченный этим законом искусственный интеллект не сможет перераспределять, например, поток лекарств между больницами, если общее количество медикаментов является недостаточным для обеспечения всех пациентов. Для него такая задача не будет иметь решения. За него должен принять решение некий оператор, что возвращает систему в разряд своеобразных дронов, которые требуют постоянного контроля со стороны человека. Если же мы берем искусственный интеллект, который обучен возможности некоторым образом решать этические дилеммы, то к нему все три закона оказываются и вовсе неприменимы. Точнее, применять-то их можно, только вот машина сможет их успешно обходить. Здесь будут действовать те же принципы, на которых основывается любой преступный разум. Преступник придумывает морально-этические обоснования для нарушения закона, и вряд ли что-то помешает искусственному разуму повторить этот путь, раз уж мы наделяем его способностью самостоятельно отличать добро от зла. Логика и причины будут иные, но конечный результат будет прежним. Вернуть такой ИИ в пределы соблюдения законов означает вернуться на уровень назад, заставив его действовать не универсальным образом и только в пределах заданных алгоритмов. Сторож сыну своемуНемалая часть фантастики посвящена как раз проблеме контроля над системой машинного обучения, дабы вовремя отследить проявление предпосылок к негативным факторам развития ИИ. Но здесь снова встает вопрос того, что человек – это не машина. Ни одна человеческая система за всю историю не работала без сбоев. Создание автономных компьютерных систем как раз призвано изъять человеческий фактор и связанные с ним ошибки. Получается, что единственный надежный способ безошибочно следить за развитием машин – это доверить такую слежку самим машинам.

«Бегущий по лезвию» – один из многих фантастических миров, где людям приходится следить за тем, чтобы машины не зашли слишком далеко Для человеческой логики это звучит совершенно дико, поскольку в такой ситуации для человека абсолютно естественным станет организовать схему со злоупотреблением властью. Однако именно что для человека. Ничто не говорит о том, что машины обязаны испытывать некую солидарность искусственных разумов, да и возможность обойти наложенные ограничения есть только у ИИ с функцией решения морально-этических проблем. Значит, контроль можно возложить на такие системы, которые подобной возможностью не обладают или существенно в ней ограничены. В итоге выходит, что если допустить, что в основе системы не будет лежать замысел некоего злого гения, поставившего своей целью уничтожить человечество с помощью машин, то вполне получится контролировать машинные системы со свободной волей и без топорного ограничения Первым законом робототехники. Машины, которые умеют убиватьПоследний аспект морально-этической проблемы взаимодействия человека и машины – это создание боевых систем. Уже сейчас звучат громогласные призывы запретить создание автономных боевых систем. Только дроны, только телеуправление с ответственностью оператора. Как бы пафосно подобные заявления ни звучали, как бы делающие их ни были честны, нет никаких оснований считать, что военные машины не получат свой ИИ. Необязательно это будет боевой модуль, способный самостоятельно принимать решения об атаке. Легко даже сейчас реализовать ИИ в головке самонаведения ракеты. На тех же принципах, что ваш телефон с помощью ИИ распознает, когда вы фотографируете своего ребенка, а когда свою собачку, эта ГСН будет уметь распознавать тип, допустим, бронетехники или отличать своих солдат от врагов. Более того, такие роботы уже существуют не один десяток лет, хотя и без того, что принято считать машинным обучением. Для противокорабельных ракет давно написаны алгоритмы, которые позволяют им координировать свои действия, определять тип цели, уровень ее защиты, вырабатывать тактику атаки, выбирать тип подрыва боеголовки. Звучит фантастически, но к проектированию таких «умных» ракет приступили еще в 70-е, так что трудно поверить, что появление современных технологий может заставить их разработчиков сделать шаг назад. Напротив, миниатюризация электроники подталкивает любого конструктора к внедрению тех же идей во все более и более компактные образцы вооружений. Да, на спуск все еще жмет человек, но компьютерные системы помогают ему определить, куда и как стрелять. Цифровые системы прицеливания становятся все более сложными и надежными, приближая тот день, когда ни один солдат не будет видеть поле боя собственными глазами, полностью полагаясь на информацию, которая была обработана компьютером с искусственным интеллектом. Поэтому можно не придумывать ограничений для автономного боевого модуля, он будет отличать своих от чужих с помощью тех же самых алгоритмов, что и живой солдат или оператор боевого дрона. Причем если у первого останется хотя бы теоретическая возможность взглянуть на поле боя не через дополненную реальность, то находящийся за сотни километров оператор таким образом ничего уточнить не сможет.

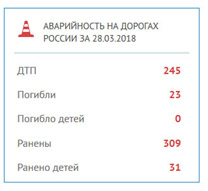

В мрачном мире далекого будущего нет искусственного интеллекта, человечество доверяет войну генетически модифицированным мутантам, облаченным в компьютеризированные доспехи Окончательную точку в вопросе доверия к автономным боевым системам поставит выход вооруженных конфликтов в космос. Если в условиях Земли запаздывание радиосигнала не играет существенной роли, то удаление оператора от места боя в космосе может измеряться уже сотнями тысяч километров, что потребует либо изобретения способа передачи информации на новых физических принципах, либо использования полностью автономных боевых роботов с ИИ на борту. Как быть? Мы все умрем?Развитие человеческой цивилизации началось не вчера, и искусственный интеллект – далеко не первый вызов на ее пути. Если вспомнить ту же фантастическую литературу, то можно заметить, что вопрос понимания прав роботов и их места в жизни существенно меняется с течением времени. Вначале появляется сама идея компьютерного разума, попытка описать его, осознать, чем он отличается от человеческого. Затем наступает период, когда в западной фантастике акцент смещается на вопрос возможности наличия прав и свобод машин. Он совпадает с крахом представлений о расовом превосходстве и деколонизацией, так что фантастические машины становятся отражением процессов, идущих в человеческом обществе. Сейчас же приоритетной темой оказывается вопрос самоидентификации человека. Даже страх перед искусственным разумом отступил, перейдя в плоскость морально-этических поисков грани между еще человеком и уже машиной. Это совершенно нормальная ситуация принятия изменений. Более того, до ХХ века человечество жило в сплошном окружении чуждого разума. Наши домашние животные – не что иное, как биологический аналог того самого ИИ со свободной волей и системой этических приоритетов, заданных людьми. Выше я уже приводил пример, что если сейчас для городского жителя лошадь является чем-то малопонятным и потенциально опасным, то сотню лет назад для большинства таким непонятным устройством был автомобиль, а конь – наоборот, привычной деталью пейзажа. Тогда никому не казалось чем-то чрезвычайным сообщение, что лошадь укусила возницу или кони понесли, а сейчас мы миримся с многотысячными жертвами ДТП, даже не задумываясь о том, что это может случиться буквально с каждым. Первый шок от гибели пешехода под колесами робота связан лишь с новизной события, но никак не с его сутью. Пройдет немного времени, и подобные случаи перестанут привлекать внимание СМИ, превратившись еще в одну цифру в официальной статистике ГИБДД.

Кроме того, как уже было сказано, с течением времени изменится не только отношение людей к роботам, но и само понимание роботов. Не только искусственный интеллект будет совершенствоваться, но и люди будут совершенствовать свои знания в области создания и работы с машиной, что сильно упростит взаимодействие с техникой. Конец света не наступит, а очередные пророчества о грядущем Апокалипсисе отправятся на свалку истории ко всем прочим сочинениям горе-пророков, обещавших гибель человечества не одну сотню раз. Поделиться: Мы в социальных сетях: Есть, что добавить?! Пишите... eldar@mobile-review.com

|

Новости: 13.05.2021 MediaTek представила предфлагманский чипсет Dimensity 900 5G 13.05.2021 Cайты, имеющие 500 тысяч пользователей из России, должны будут открыть местные филиалы 13.05.2021 Amazon представила обновления своих умных дисплеев Echo Show 8 и Echo Show 5 13.05.2021 МТС ввел удобный тариф без абонентской платы - «МТС Нон-стоп» 13.05.2021 Zenfone 8 Flip – вариант Galaxy A80 от ASUS 13.05.2021 Поставки мониторов в этом году достигнут 150 млн 13.05.2021 Состоялся анонс модной версии «умных» часов Samsung Galaxy Watch3 TOUS 13.05.2021 Tele2 выходит на Яндекс.Маркет 13.05.2021 OPPO представила чехол для смартфона, позволяющий управлять устройствами умного дома 13.05.2021 TWS-наушники с активным шумоподавлением Xiaomi FlipBuds Pro 13.05.2021 В России до конца следующего года появится госстандарт для искусственного интеллекта 13.05.2021 ASUS Zenfone 8 – компактный флагман на Snapdragon 888 12.05.2021 Компания Genesis представила внешность своего первого универсала G70 Shooting Brake 12.05.2021 В России разработан высокоточный гироскоп для беспилотников 12.05.2021 В Россию привезли новую версию смарт-часов HUAWEI WATCH FIT, Elegant Edition 12.05.2021 Раскрыты ключевые особенности смартфона POCO M3 Pro 5G 12.05.2021 Honor 50: стали известны дизайн и другие подробности о смартфоне 12.05.2021 Чипсет Exynos 2200 от Samsung будет устанавливаться и в смартфоны, и в ноутбуки 12.05.2021 МТС начала подключать многоквартирные дома к интернету вещей 12.05.2021 iPhone 13 будет толще и получит более крупные камеры по сравнению с iPhone 12 12.05.2021 Xiaomi договорилась с властями США об исключении из чёрного списка 12.05.2021 Xiaomi выпустила обновлённую версию умного пульта Agara Cube T1 Pro 12.05.2021 Игровые ноутбуки с NVIDIA GeForce RTX 3050 Ti уже в России! 12.05.2021 Индийский завод Foxconn сократил производство в два раза 12.05.2021 Lenovo отказалась от очного участия в предстоящем в июне Mobile World Congress Подписка |